默认 136

-

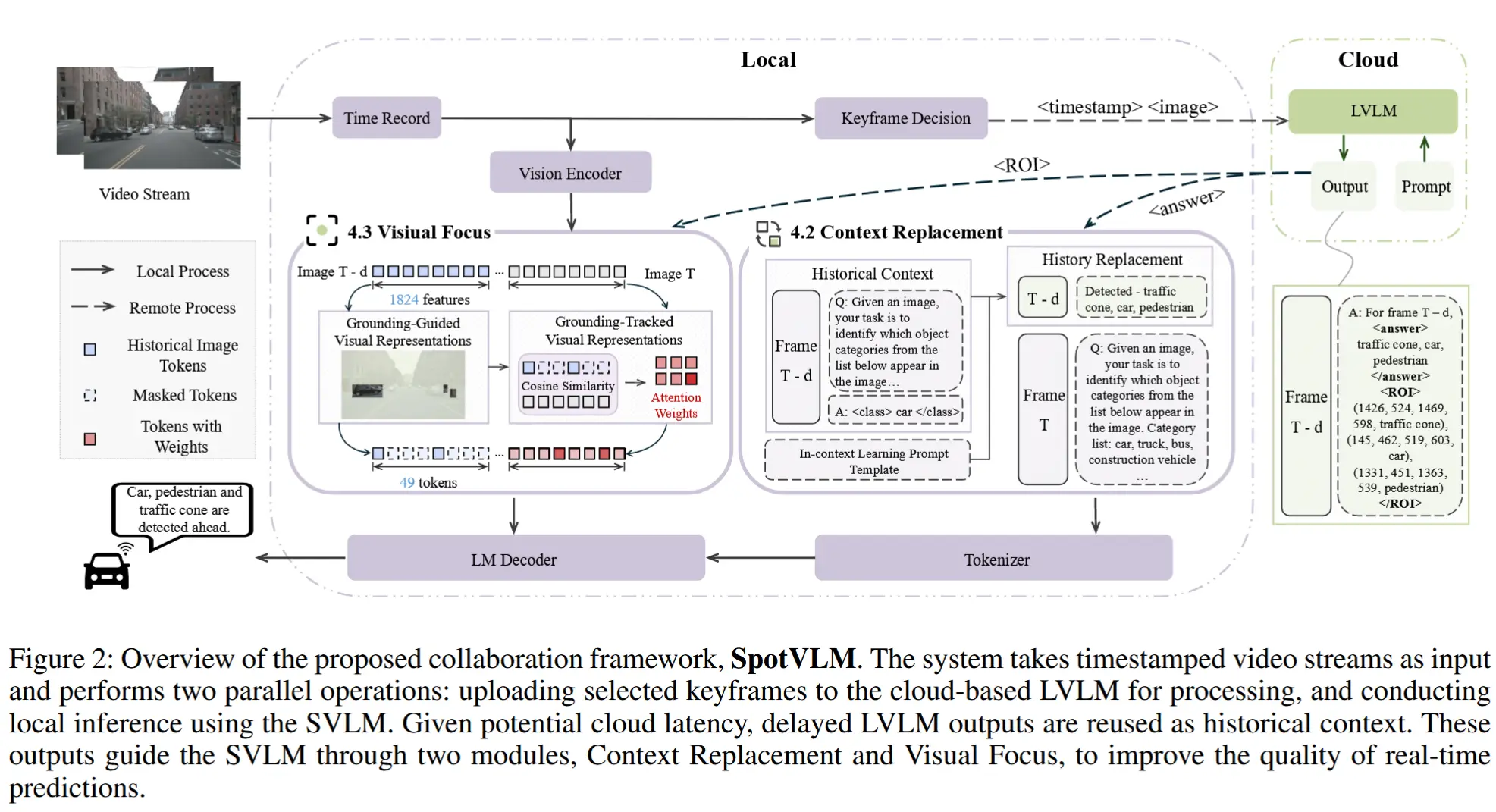

论文笔记《SpotVLM: Cloud-edge Collaborative Real-time VLM based on Context Transfer》

论文 - 《SpotVLM: Cloud-edge Collaborative Real-time VLM based on Context Transfer》 关键词 - 云边协同、视觉-语言大模型VLM、文本上下文、视觉聚焦、大小模型混合、实时视频 这篇介绍了一种新的大小模型协同方式,大模型通过

-

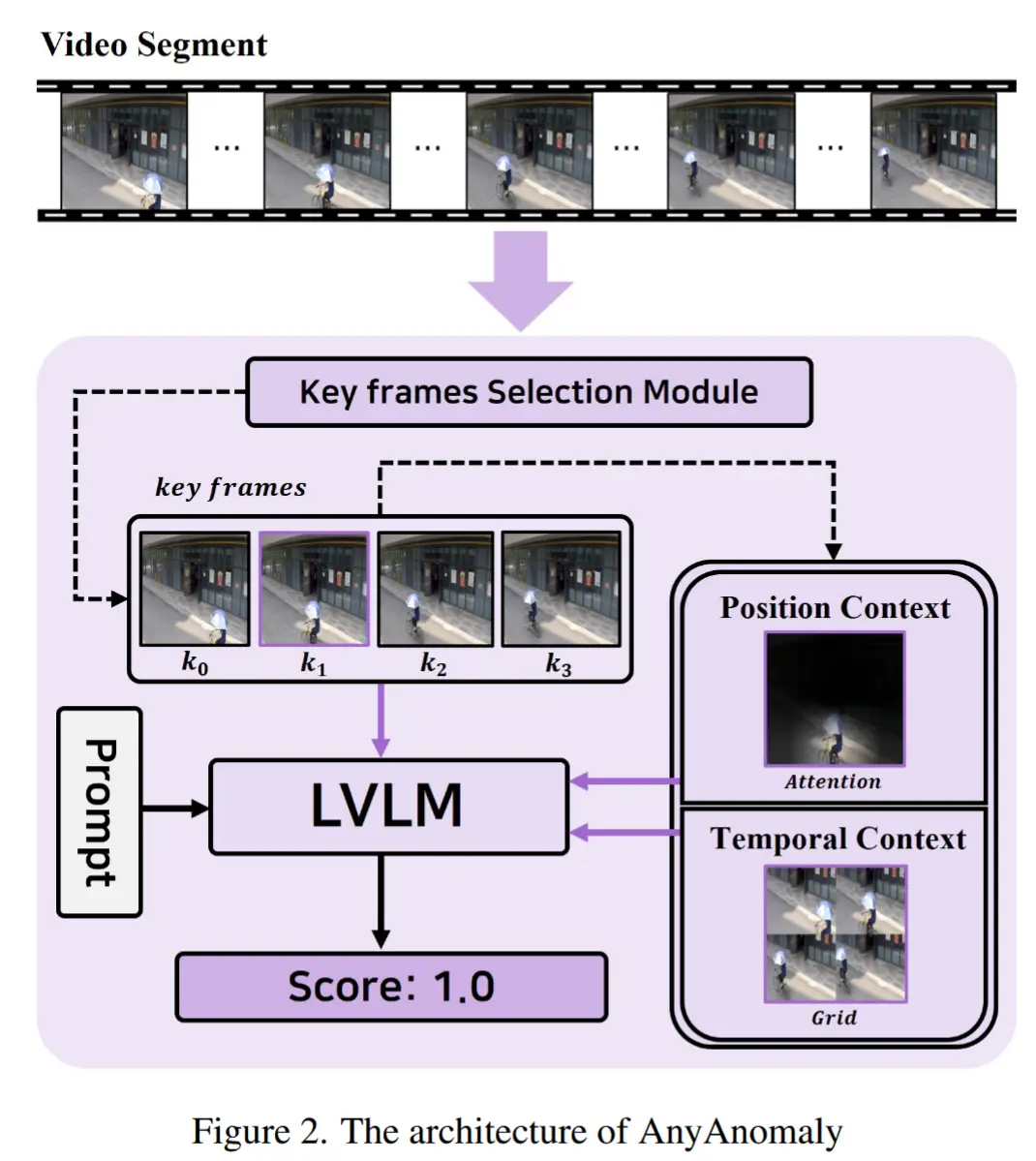

论文笔记《AnyAnomaly: Zero-Shot Customizable Video Anomaly Detection with LVLM》

论文 - 《AnyAnomaly: Zero-Shot Customizable Video Anomaly Detection with LVLM》 代码 - Github 关键词 - 关键帧采样、无需微调/训练、零样本、视频异常检测、视觉语言模型VLM 这篇论文主要是利用VLM的通用泛化能力来实

-

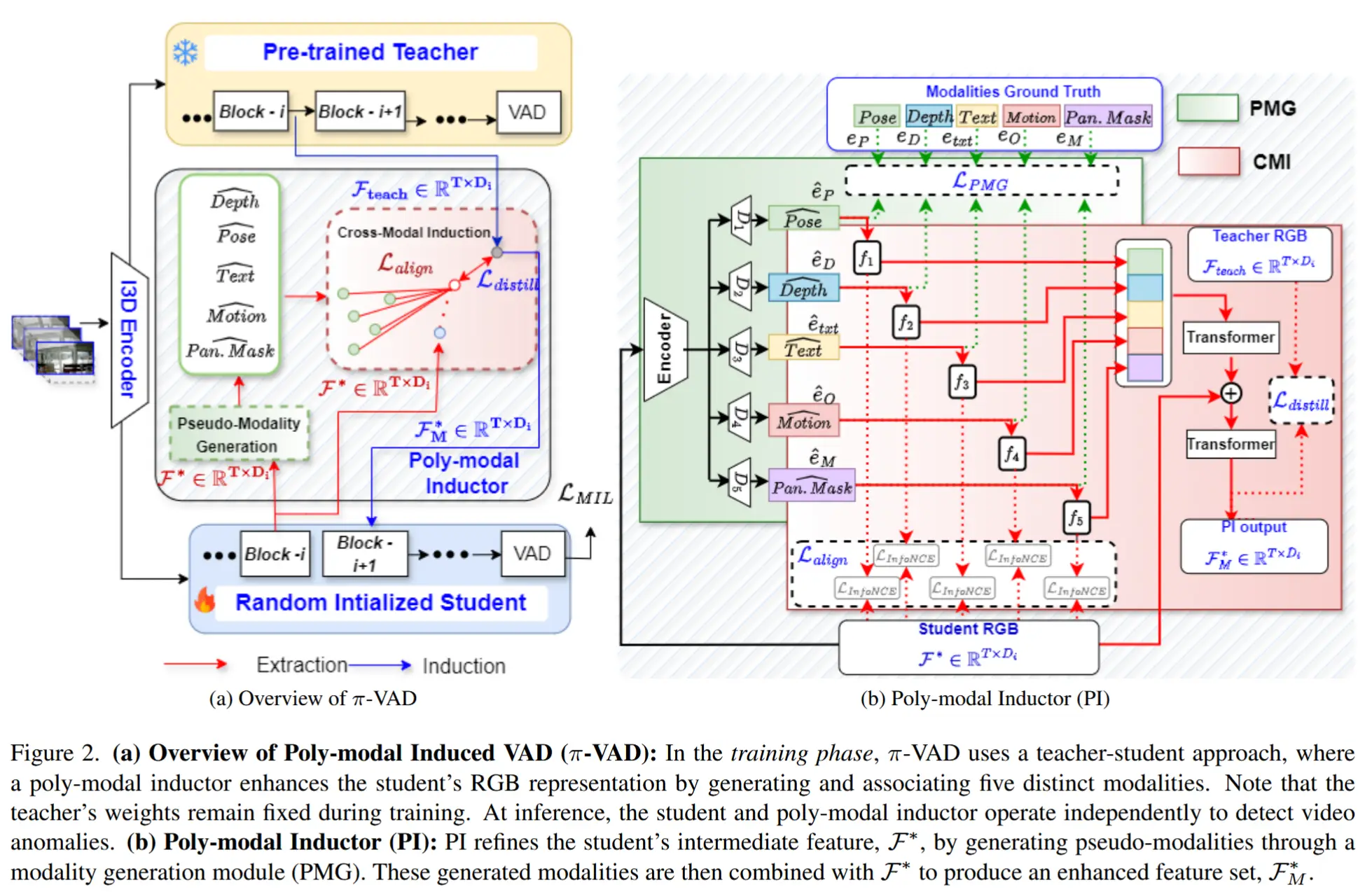

论文笔记《Just Dance with π! A Poly-modal Inductor for Weakly-supervised Video Anomaly Detection》

论文 - 《Just Dance with π! A Poly-modal Inductor for Weakly-supervised Video Anomaly Detection》 代码 - 仓库关闭了 关键词 - CVPR' 25、弱监督视频异常检测WSVAD、多模态融合、视频异常检测VAD

-

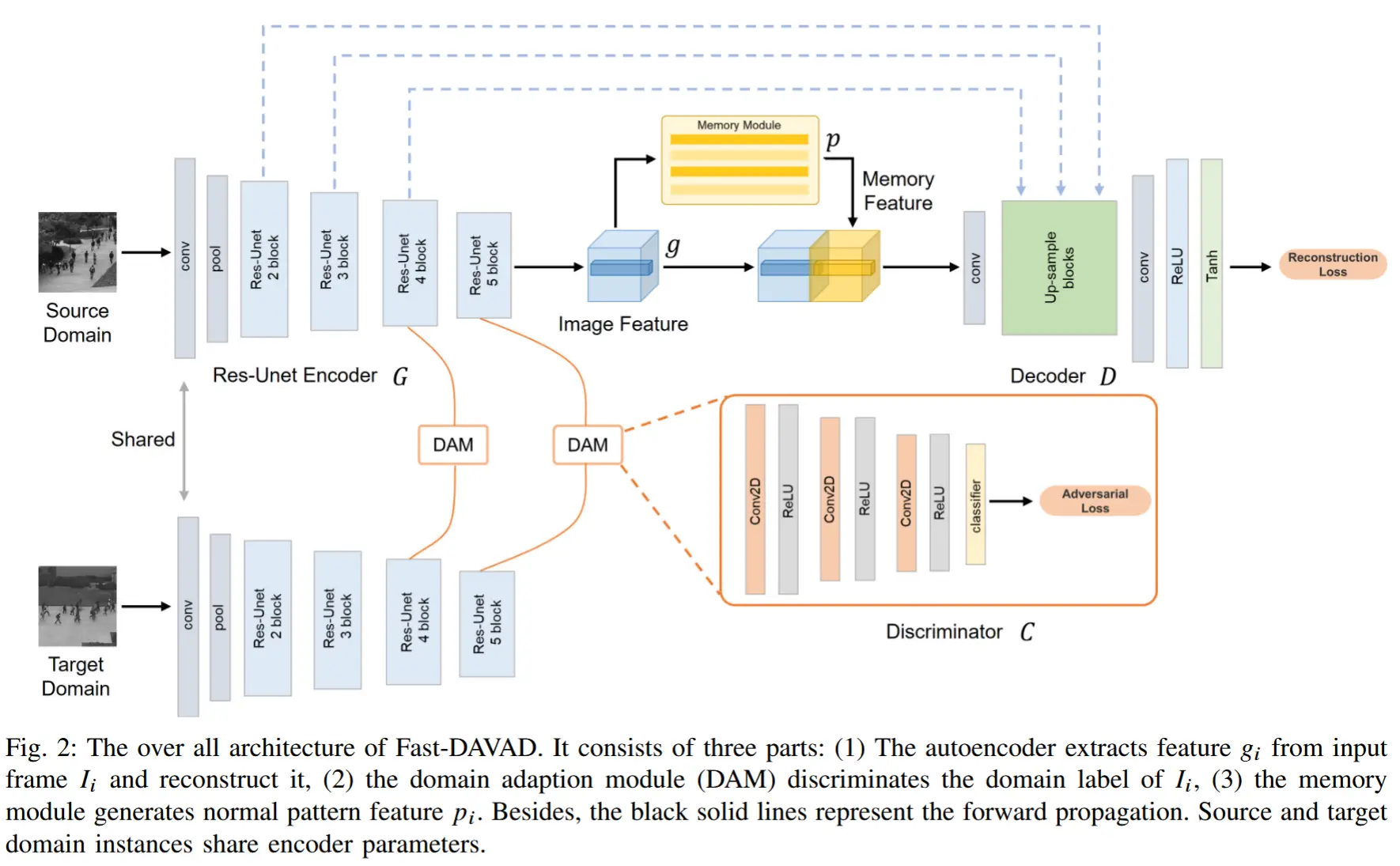

论文笔记《Fast-DAVAD : Domain Adaptation for Fast VAD on Resource-Constrained Edge Devices》

论文 - 《Fast-DAVAD : Domain Adaptation for Fast Video Anomaly Detection on Resource-Constrained Edge Devices》 关键词 - 边缘智能、域适应、视频异常检测、资源限制、对抗学习、记忆模块 1 引言

-

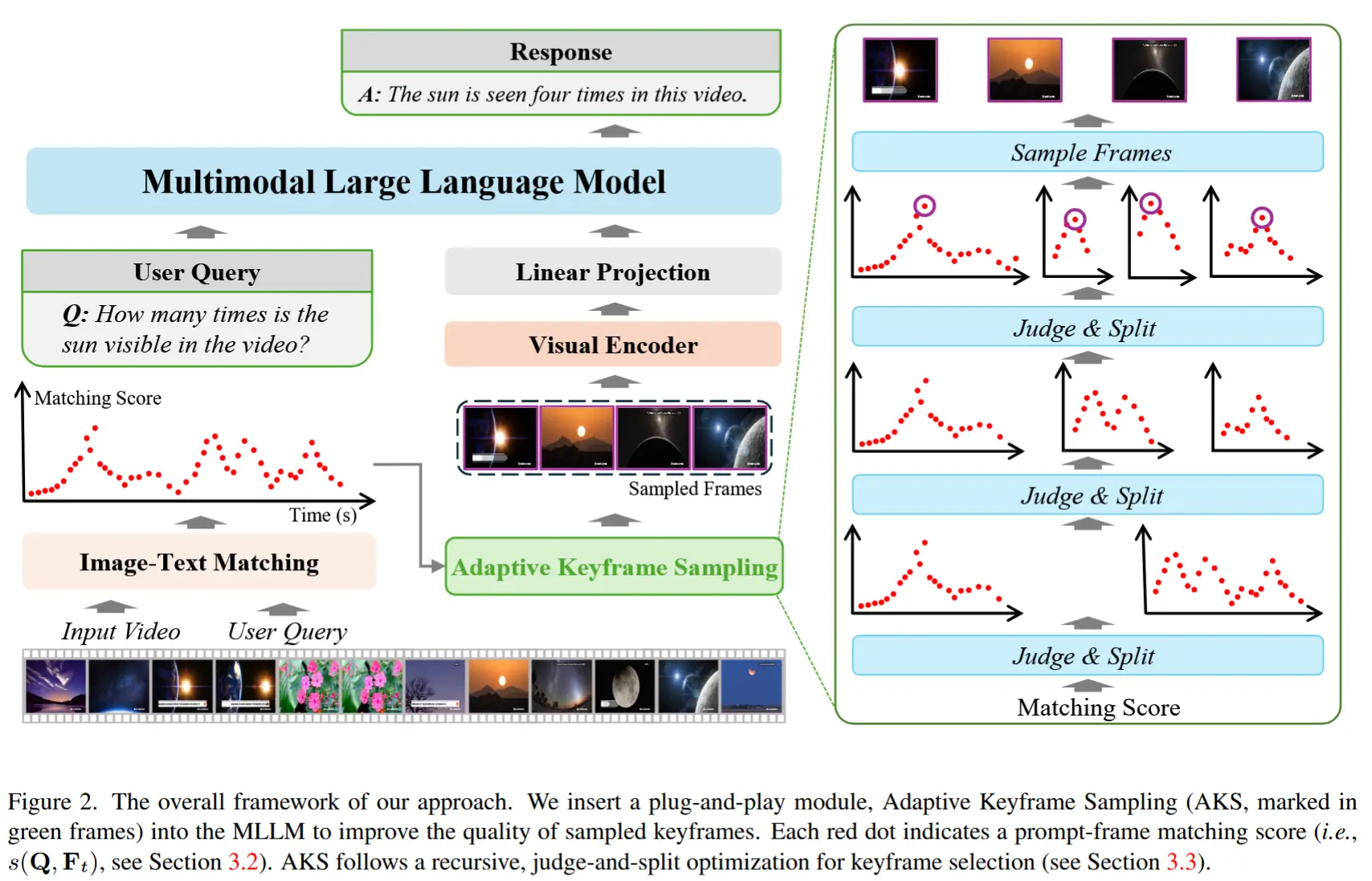

论文笔记《Adaptive Keyframe Sampling for Long Video Understanding》

论文 - 《Adaptive Keyframe Sampling for Long Video Understanding》 代码 - Github 关键词 - 自适应抽帧、多模态大模型MLLM、相关性、覆盖度、采样 1 引言 研究问题 MLLMs 通过将视觉输入作为额外的标记注入到 LLMs 中作

-

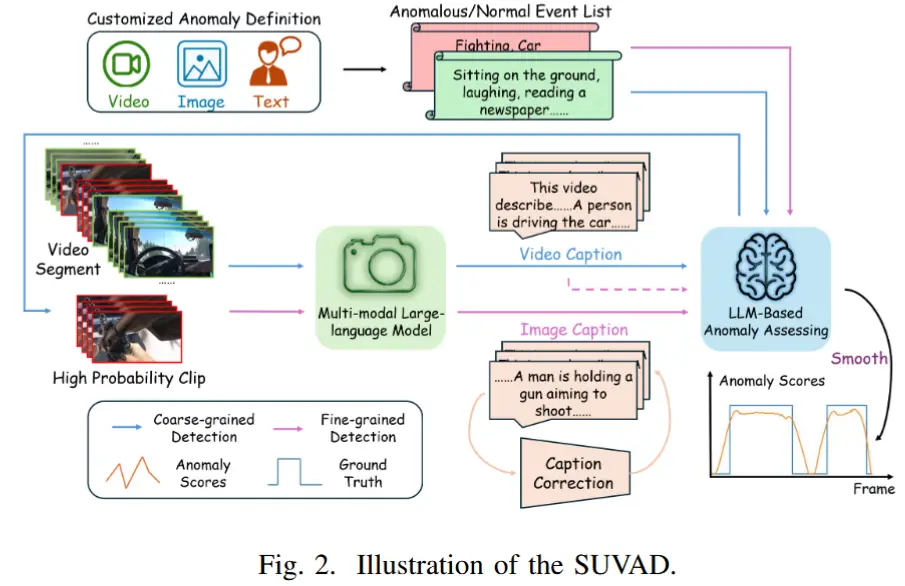

论文比较《SUVAD: Semantic Understanding Based Video Anomaly Detection Using MLLM》

论文 - 《SUVAD: Semantic Understanding Based Video Anomaly Detection Using MLLM》 关键词 - ICASSP2025、无需训练的、多模态大模型、视觉-语言模型、视频异常检测 1 引言 现有工作不足 这些方法大多依赖特定场景,一旦

-

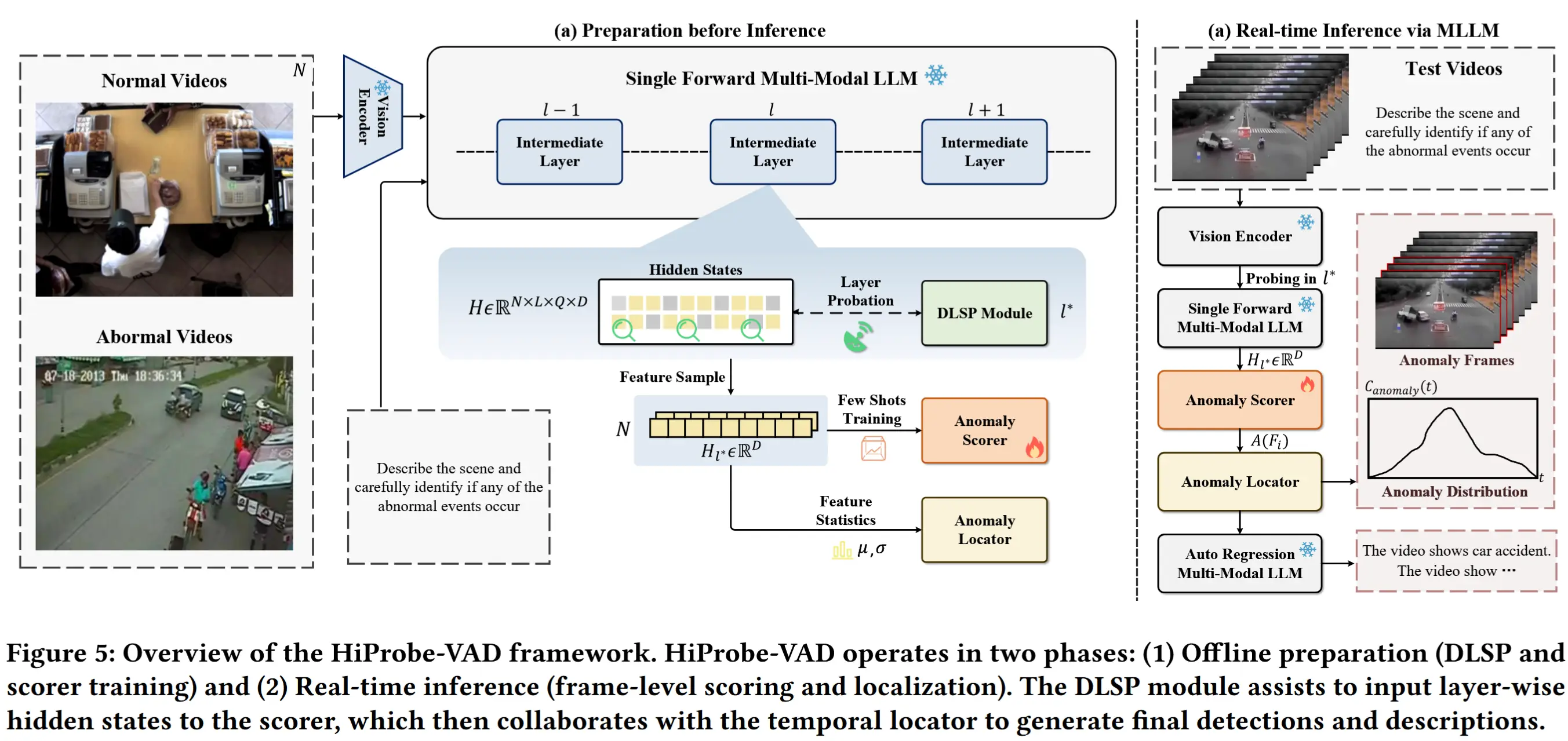

论文笔记-《HiProbe-VAD: Video Anomaly Detection via Hidden States Probing in Tuning-Free Multimodal LLMs》

论文 - 《HiProbe-VAD: Video Anomaly Detection via Hidden States Probing in Tuning-Free Multimodal LLMs》 关键词 - ACM MM '25、多模态大模型MLLM、中间隐藏状态、免微调 1 引言 现有工作的

-

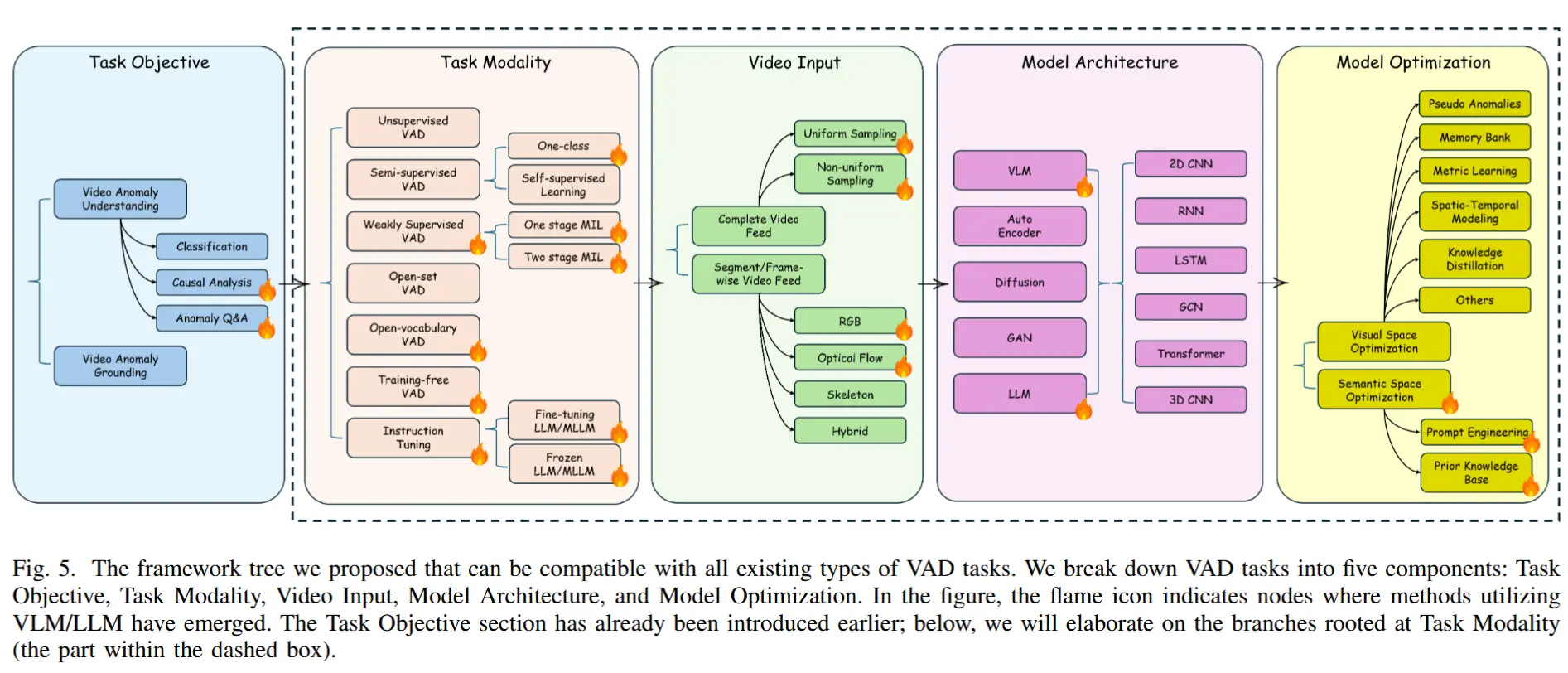

论文笔记《The Evolution of Video Anomaly Detection: A Unified Framework from DNN to MLLM》

论文 - 《The Evolution of Video Anomaly Detection: A Unified Framework from DNN to MLLM》 关键词 - 综述、视频异常检测、多模态大模型 这是一篇综述文章,深入介绍了MLLM和LLM技术在VAD领域的应用,并且按照多种V

-

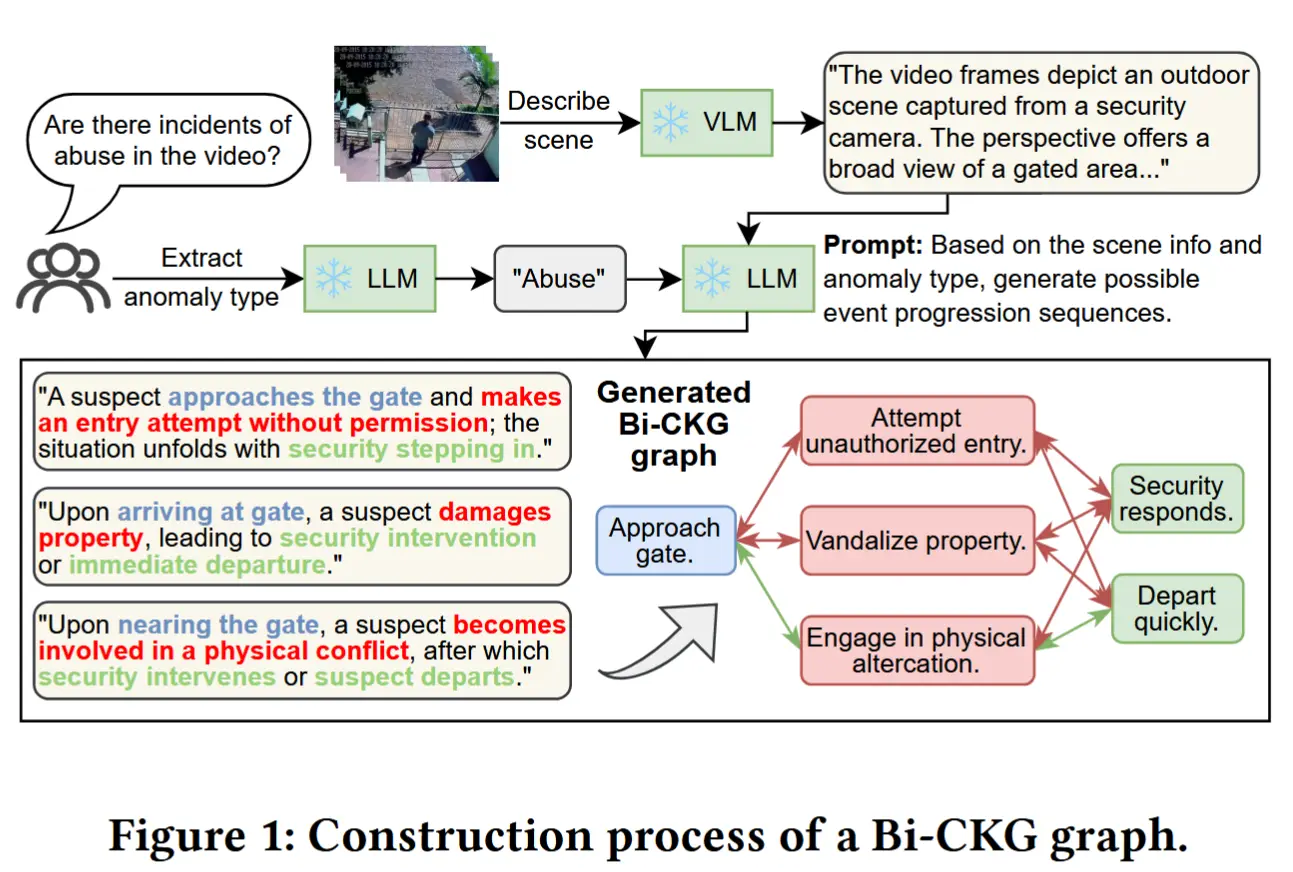

论文笔记《HoloTrace: LLM-based Bidirectional Causal Knowledge Graph for Edge-Cloud VAD》

论文 - 《HoloTrace: LLM-based Bidirectional Causal Knowledge Graph for Edge-Cloud Video Anomaly Detection》 代码 - Github 关键词 - ACM MM2025、边缘-云协作、知识图谱、视频异常检

-

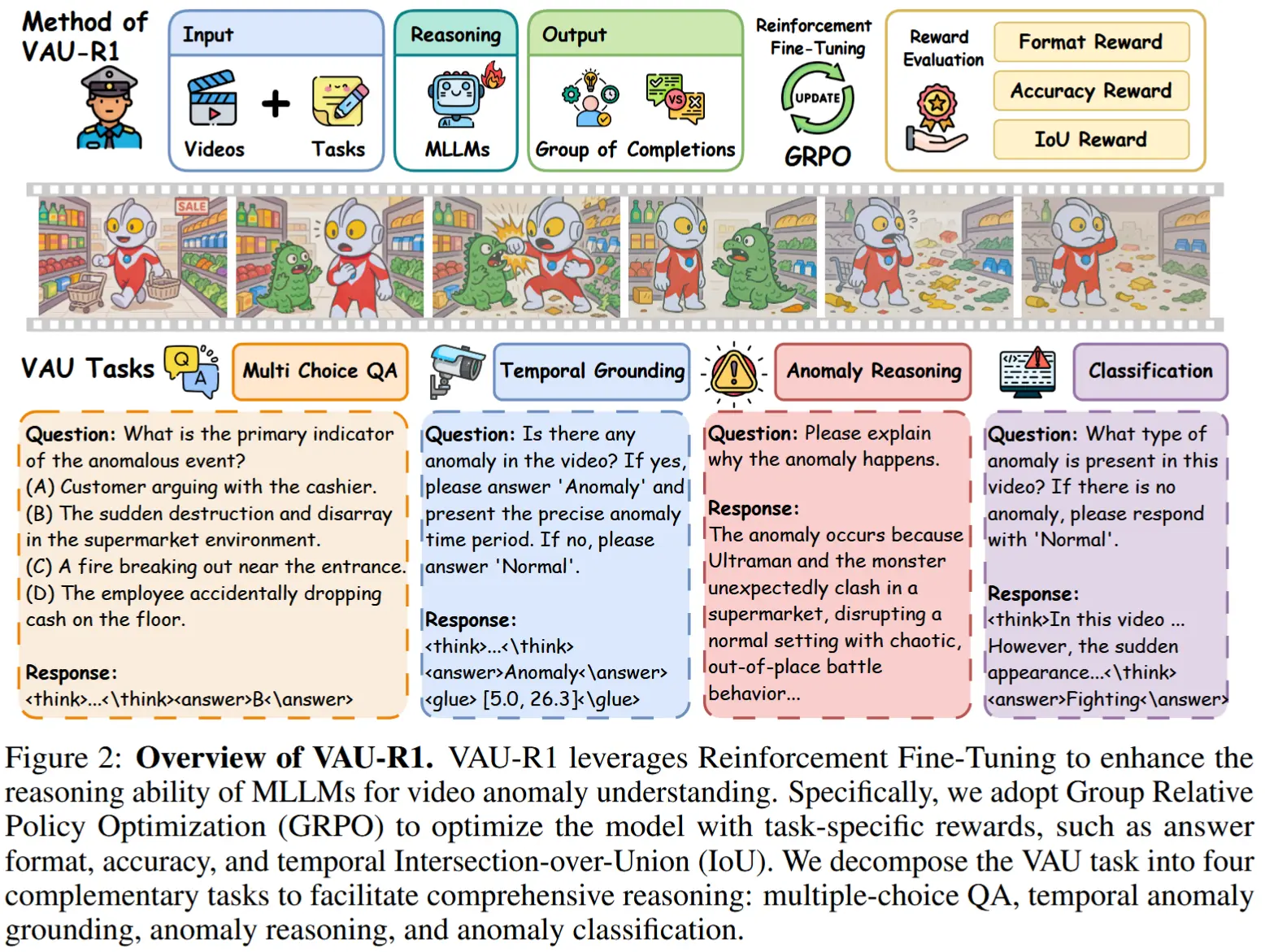

论文笔记《VAU-R1: Advancing Video Anomaly Understanding via Reinforcement Fine-Tuning》

论文 - 《VAU-R1: Advancing Video Anomaly Understanding via Reinforcement Fine-Tuning》 代码 - Github 关键词 - 强化微调、Qwen、视频异常理解VAU、新数据集、视频异常问答、视频异常检测VAD、新基准 1 引

-

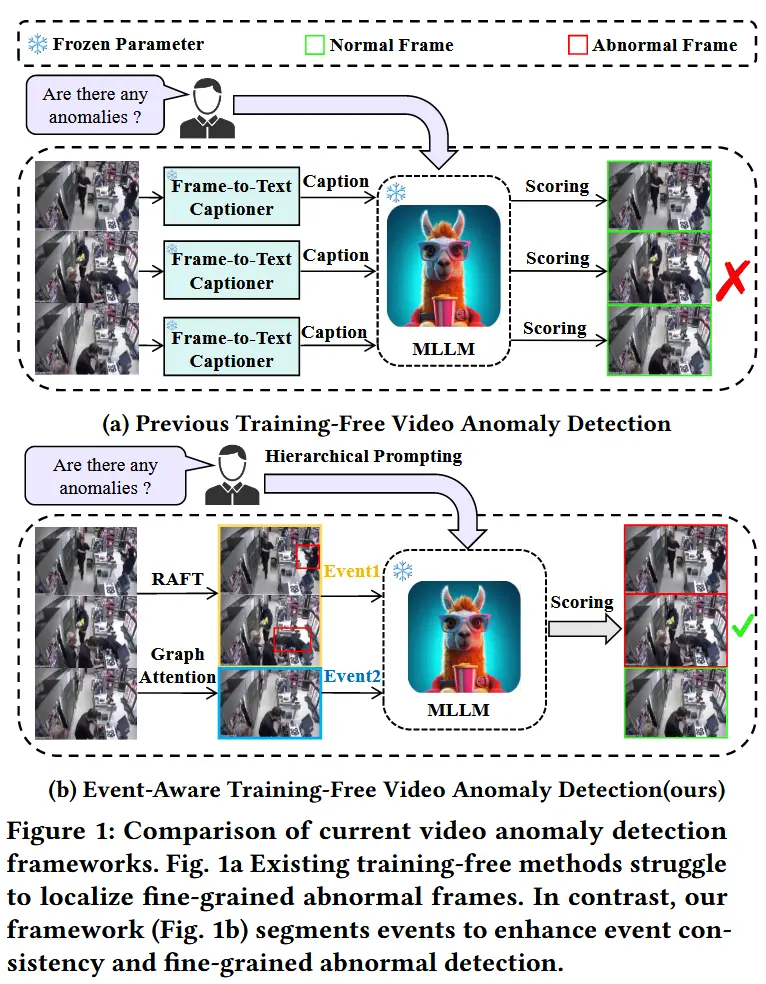

论文笔记《EventVAD: Training-Free Event-Aware Video Anomaly Detection》

论文 - 《EventVAD: Training-Free Event-Aware Video Anomaly Detection》 代码 - Github 关键词 - 无需训练、视频异常处理、图注意力网络、异常边界判定、视频大模型VideoLLaMA 1 引言 研究问题 视频异常检测(VAD)致力

-

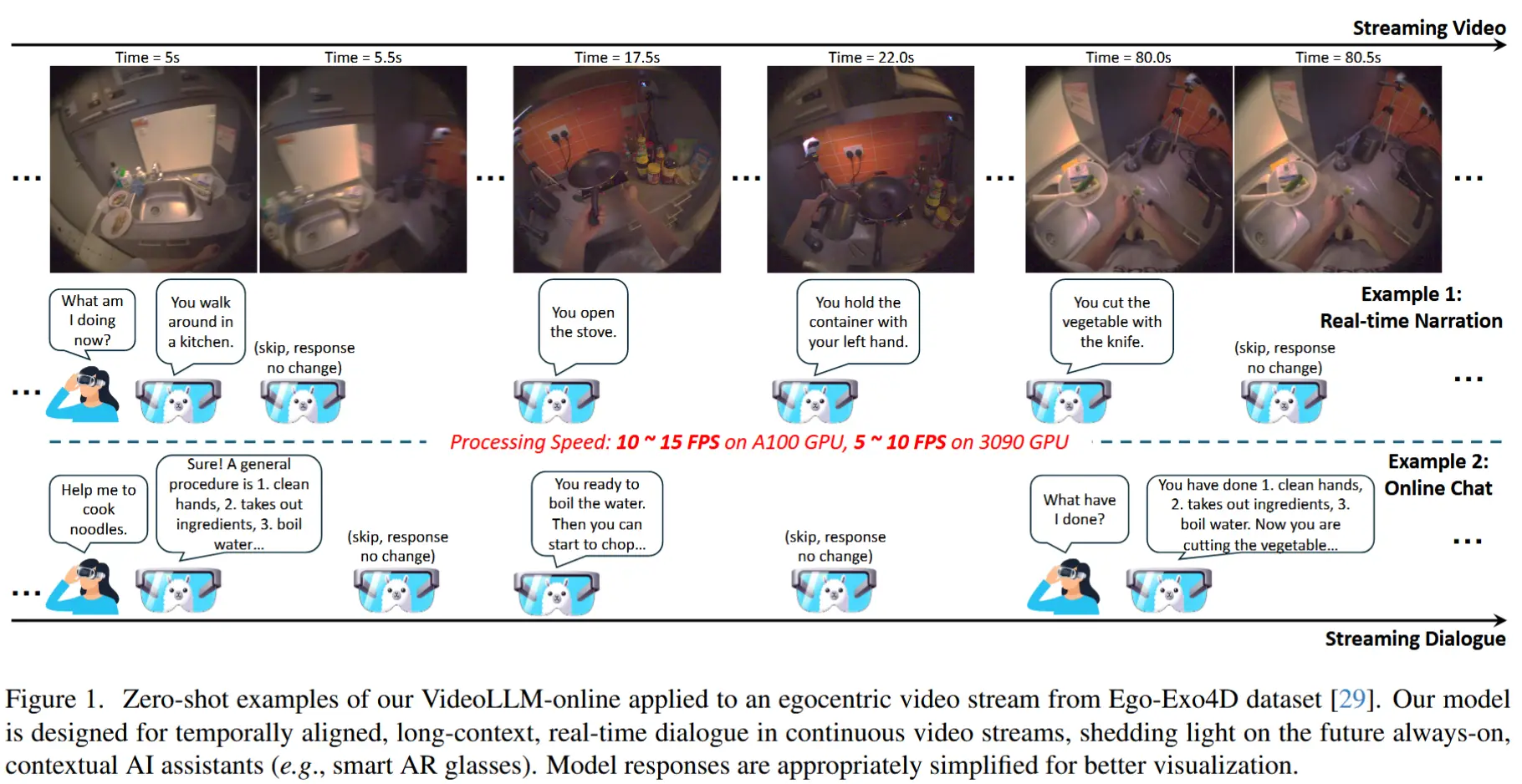

论文笔记《VideoLLM-online: Online Video Large Language Model for Streaming Video》

论文 - 《VideoLLM-online: Online Video Large Language Model for Streaming Video》 代码 - Github 关键词 - 流式视频、在线视频问答、视频大模型 1 引言 研究动机 现有大模型训练时通常将视频视为预定义的视频片段,导致

-

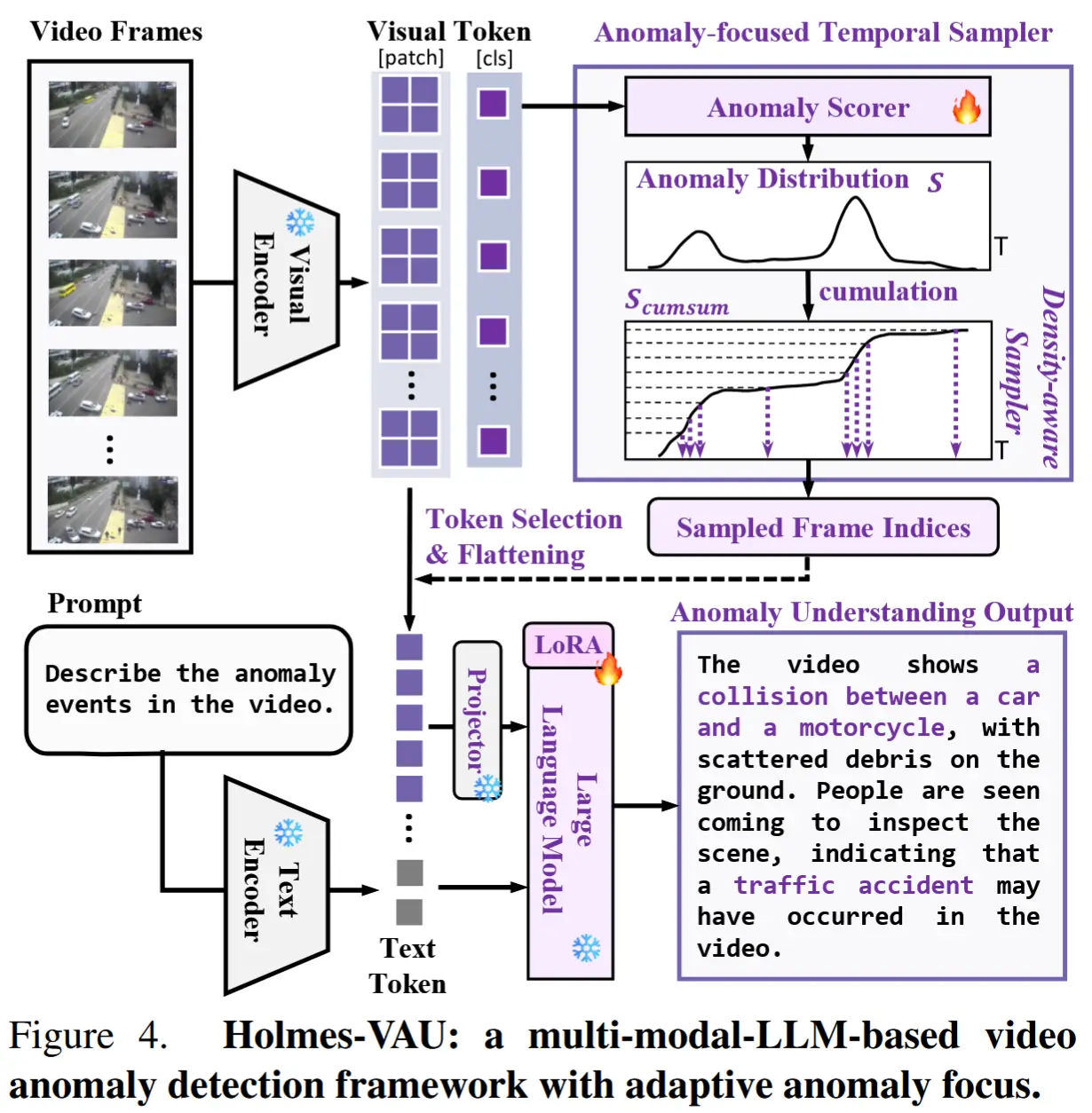

论文笔记《Holmes-VAU: Towards Long-term Video Anomaly Understanding at Any Granularity》

论文 - 《Holmes-VAU: Towards Long-term Video Anomaly Understanding at Any Granularity》 代码 - Github 关键词 - 指令微调数据集、InterVL2、视频大模型、视觉-语言大模型VLM、视频异常检测VAD、时序采

-

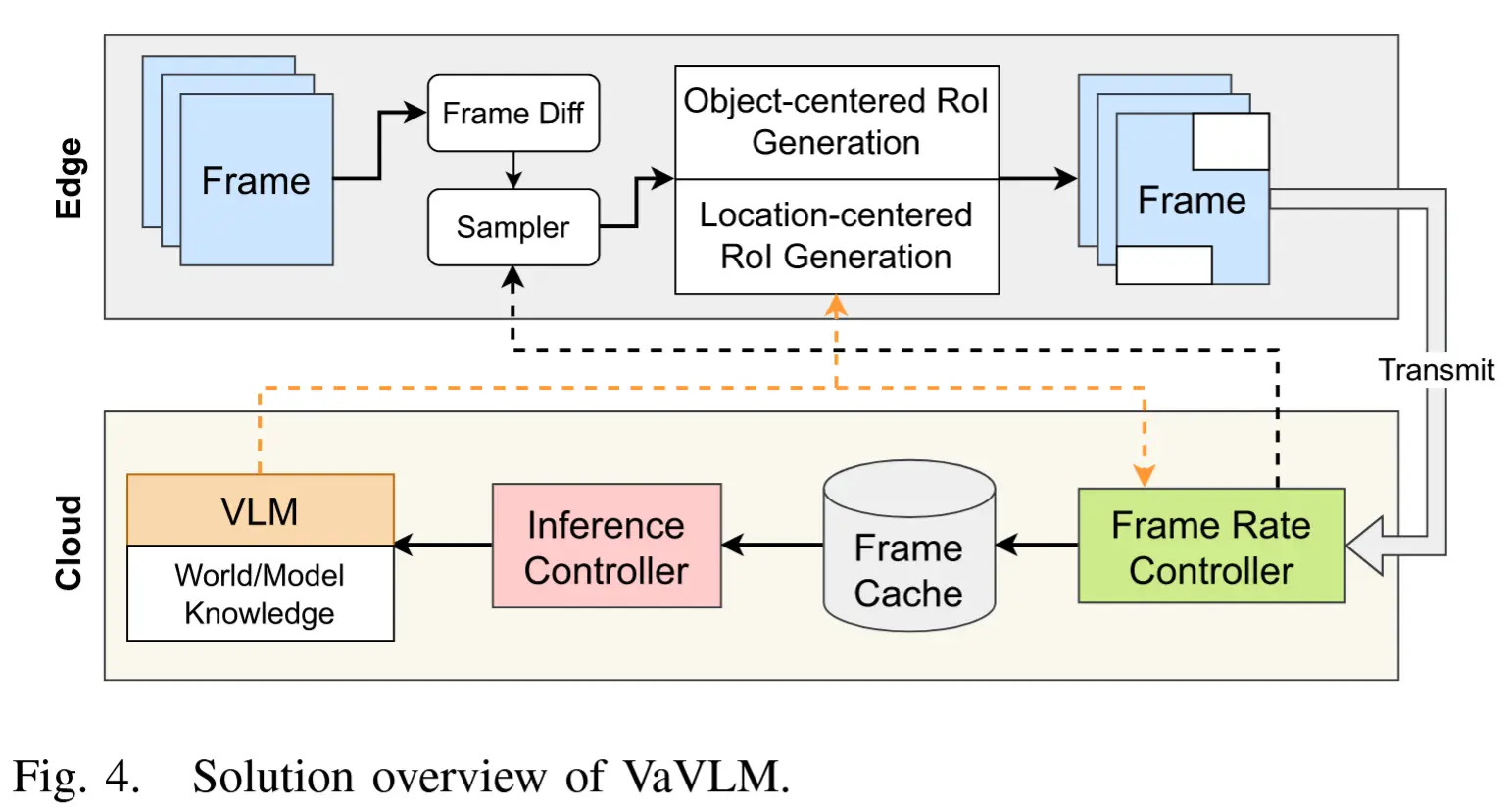

论文笔记《VaVLM: Toward Efficient Edge-Cloud Video Analytics With Vision-Language Models》

论文 - 《VaVLM: Toward Efficient Edge-Cloud Video Analytics With Vision-Language Models》 关键词 - 边缘智能、端云协作、边缘设备、任务特定推理、视频大模型、自适应抽帧、感兴趣区域 Rol、边缘推理 1 引言 现有工作

-

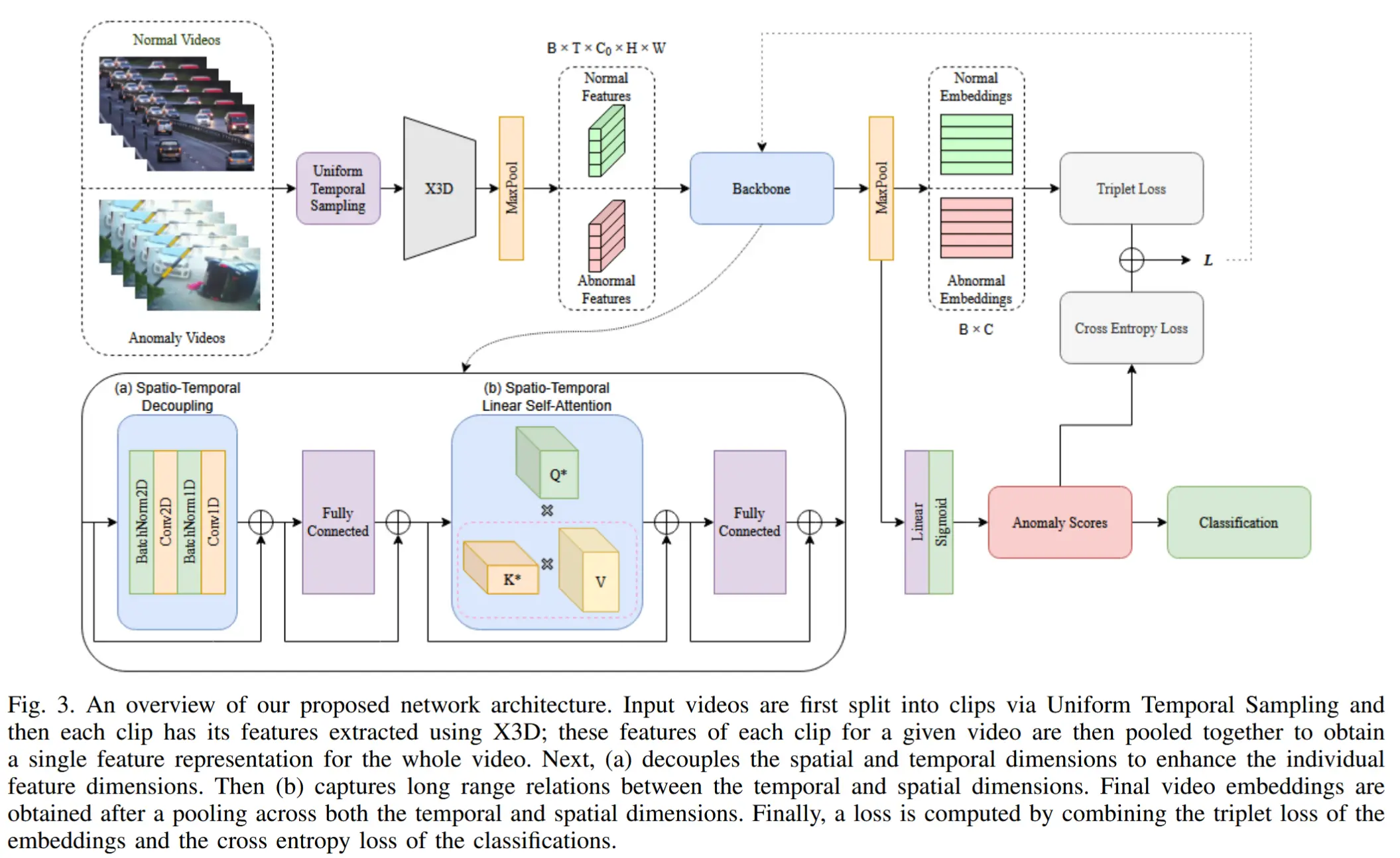

论文笔记《STEAD: Spatio-Temporal Efficient Anomaly Detection for Time and Compute Sensitive Applications》

论文 - 《STEAD: Spatio-Temporal Efficient Anomaly Detection for Time and Compute Sensitive Applications》 代码 - Github 关键词 - 实时推理、轻量化、时空建模、视频异常检测VAD、I3D、X3

-

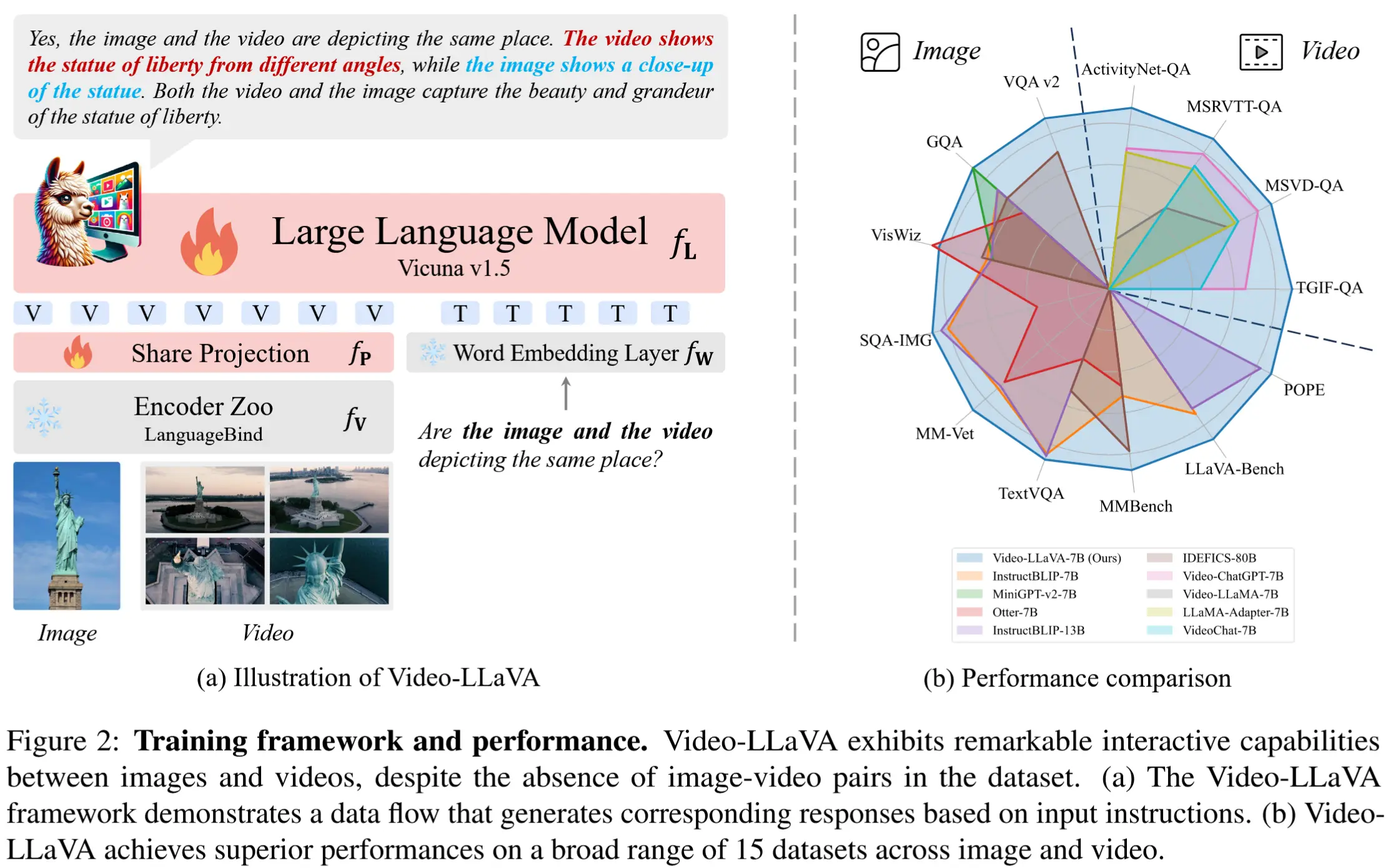

论文笔记《Video-LLaVA: Learning United Visual Representation by Alignment Before Projection》

论文 - 《Video-LLaVA: Learning United Visual Representation by Alignment Before Projection》 代码 - Github 关键词 - 微调、LanguageBind、Vicuna、视频大模型、视觉-语言大模型 0 比较不

-

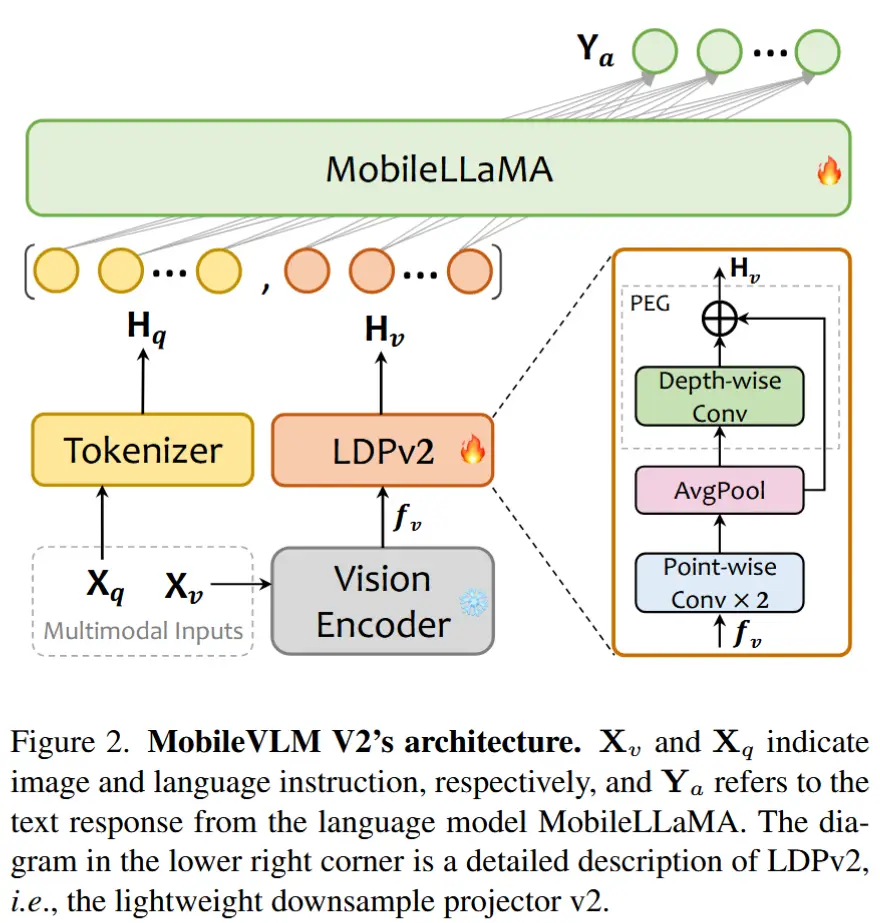

论文笔记《MobileVLM V2: Faster and Stronger Baseline for Vision Language Model》

论文 - 《MobileVLM V2: Faster and Stronger Baseline for Vision Language Model》 代码 - Github 关键词 - 边缘智能、高效大模型、视觉-语言模型VLM 1 引言 动机:打造小型视觉-语言模型VLM。 本文工作 - Mob

-

论文笔记《Follow the Rules: Reasoning for Video Anomaly Detection with Large Language Models》

论文 - 《Follow the Rules: Reasoning for Video Anomaly Detection with Large Language Models》 代码 - Github 关键词 - 无需训练、Prompt 工程、视频异常检测VAD、视觉-语言模型VLM、基于规则推理

-

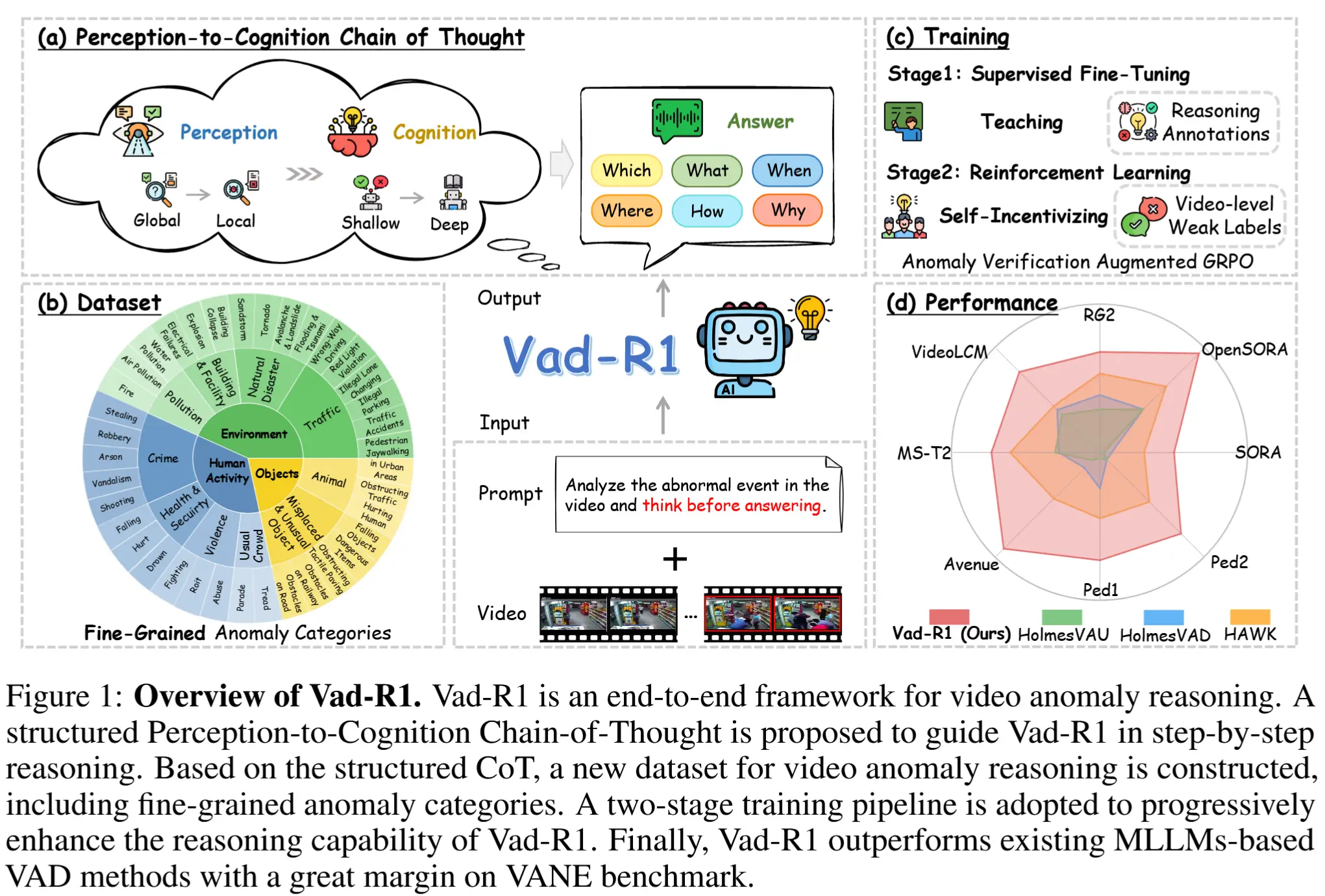

论文笔记《Vad-R1: Towards Video Anomaly Reasoning via Perception-to-Cognition Chain-of-Thought》

论文 - 《Vad-R1: Towards Video Anomaly Reasoning via Perception-to-Cognition Chain-of-Thought》 代码 - Github 关键词 - reason推理能力、思维链COT、多模态大语言模型MLLMs、强化学习、新数据

-

论文笔记《Flashback: Memory-Driven Zero-shot, Real-time Video Anomaly Detection》

论文 - 《Flashback: Memory-Driven Zero-shot, Real-time Video Anomaly Detection》 关键词 - 实时高效视频异常检测、基于记忆库、零样本、可解释性、视觉语言大模型VLM、无需训练 1 引言 VAD 有两个根本性的障碍阻碍了其在现实