摘要

- 研究背景

- 大多数LMM (large multimodal models) 的推理请求来自边缘设备,目前主流的推理流程是直接将输入数据转发到边缘服务器进行所有计算。

- 然而,这种方法因边缘设备上行带宽有限而引入了高传输延迟,同时由于视觉token数量庞大而导致显著的计算延迟,从而阻碍了对延迟敏感的任务并降低了用户体验。

- 解决办法

- 作者提出了一种面向任务的特征压缩(task-oriented feature compression,TOFC)方法,用于设备-边缘协同推理框架中的多模态理解。在该方法中,视觉特征通过聚类合并,并在特征投影之前使用可学习且选择性的熵模型进行编码。

- 具体而言,作者基于K近邻的密度峰值聚类来减少视觉特征的数量,从而降低数据传输量和计算复杂度。随后,利用带有超先验的可学习熵模型对合并后的特征进行编码和解码,进一步减少传输开销。为了提高压缩效率,根据视觉特征的特性自适应选择多个熵模型,从而更准确地估计概率分布。

- 实验效果

- 在七个视觉问答基准数据集上进行了全面实验,验证了所提出的TOFC方法的有效性。结果表明,与传统的图像压缩方法相比,TOFC在保持相同任务性能的同时,最多可减少60%的数据传输开销和50%的系统延迟。

1 介绍

-

主流LMMs处理视觉输入的架构通常由三个组件组成

- 视觉编码器 通常基于 contrastive language–image pretraining(CLIP)[9],它将图像块转换为带有语言知识的视觉特征,得益于大规模图像-文本对的预训练。

- 特征投影器 将提取的特征映射为视觉token,从而弥合CLIP与LLM之间的差距。

- LLM 处理视觉和文本token,并以自然语言生成响应。

-

问题

- 高推理延迟:基于CLIP的视觉编码器用大量特征表示一个小图像块,导致视觉token数量过多。由于注意力机制的计算复杂度随输入序列长度呈二次增长,LLMs的自回归推理会带来显著的延迟。

- 数据通信开销:大多数推理请求来自计算能力有限的边缘设备,上传到附近的边缘服务器处理。在用户设备仅依赖无线网络连接的情况下,通信信道高度动态且上行带宽通常受限。在这种信道上传输视觉数据会导致显著的延迟,阻碍了对延迟敏感任务的执行。

-

解决方案-面向任务的通信

- 核心思想:根据下游任务的特性设计传输策略,而不是在边缘服务器上恢复原始数据,从而实现了从传统以数据为中心的方法向任务导向方法的范式转变。

-

现有工作的不足之处

- 面向任务的通信:并不直接适用于LMM推理,因为LMM依赖于CLIP模型来提取适用于多样化下游任务的视觉特征,而这种依赖性导致重新训练一个受限通信开销的替代视觉编码器不切实际。

- 视觉数据压缩技术:例如传统压缩方法和神经图像压缩方法。首先,这些方法通过压缩输入图像来减少传输开销,但代价是在边缘服务器重建时图像质量会有所下降。其次,这些压缩方法旨在像素空间中恢复原始图像,它们并不会选择性地丢弃与下游任务无关的冗余信息。因此,在可用带宽高度受限的情况下,这些方法可能会扭曲对LMM推理至关重要的关键语义信息,从而损害下游任务的性能。

- 减少token数量:例如视觉编码、特征投影和LLM生成。这些方法假设整个推理过程是在单个设备上执行的,并未考虑设备-边缘协同推理框架中对数据传输的限制。由于在LMM推理过程中潜在特征始终保持高维特性,这些方法如果不结合其他特征压缩技术,则不适合用于协同推理方案。

1.1贡献

- 如图1所示,作者提出了一种面向任务的特征压缩(TOFC)方法,用于设备-边缘协同推理框架中的多模态理解。在该方法中,视觉特征通过聚类合并,并在特征投影之前使用可学习且选择性的熵模型进行编码。

- 主要贡献

- TOFC方法同时减少了数据传输开销和LMM推理的计算复杂度,从而显著降低了端到端系统的延迟,特别是在用户设备依赖上行带宽有限的无线连接时。

- 方法

- 首先,作者引入了一个特征合并模块(FMM),该模块基于K近邻的密度峰值聚类(DPC-KNN)将视觉特征划分为多个簇。 随后,对每个簇应用平均池化操作,将视觉特征的数量减少到原始数量的仅1.1%至4.4%。这种视觉token的减少不仅降低了数据传输开销,还减少了LLM处理的视觉token数量,从而缓解了边缘服务器上的GPU内存占用和计算负载。

- 其次,作者采用带有超先验的可学习熵模型对合并后的特征进行编码和解码,进一步减少数据传输开销。 合并后的特征由拉普拉斯分布建模,其均值和尺度通过学习网络从超先验中推导得出。合并后的特征和超先验均被量化并通过基于估计概率分布的熵编码器进行编码,从而在保持下游任务可接受失真的情况下获得更紧凑的比特流表示。

- 第三,为了提高估计概率分布的准确性,作者根据视觉特征的特性自适应选择多个熵模型。 每个熵模型专门用于编码特定特征,从而实现更接近实际熵的数据速率,并提升整体压缩效率。

- 实验:通过在七个视觉问答(VQA)基准数据集上进行综合实验,验证了所提出的TOFC方法的有效性。 结果表明,TOFC方法在数据传输开销和系统延迟方面均实现了显著减少。

2 相关工作

2.1 面向任务的通信

- 定义:传统的以数据为中心的传输范式专注于可靠地传输多模态输入中的每一个比特,却忽视了数据中固有的冗余性。为了解决这一局限性,面向任务的通信 提出提取与任务相关的信息,从而在减少数据传输开销的同时保持下游任务的满意性能。这一目标通过采用信息瓶颈(IB)原则 实现,该原则在最大化任务性能的同时最小化通信开销。

- 相关工作

- 文献 [35] 中的作者建立了一个时间熵模型,以最小化连续视频帧中的冗余性,同时实现了卓越的视频分析性能。

- 后续研究进一步探索了将面向任务的原则扩展到移动通信的其他场景,包括多设备协同推理 [16]、数字调制下的图像处理 [17]、领域泛化 [36] 以及自动驾驶中的协同感知 [18]。

- 局限性:上述研究主要关注传统的视觉任务,例如目标检测和分类,但目前尚无研究解决LMM推理中过高的传输开销问题。

- 克服:鉴于对LMM推理需求的快速增长,在多模态理解任务中采用面向任务的通信原则。

2.2 神经数据压缩

- 传统的视觉数据压缩方法:如JPEG 、BPG 和 WebP ,采用线性变换 [38] 在频域中获得紧凑表示,随后通过熵编码进一步去除冗余。

- 神经压缩方法:利用神经网络提取潜在特征,并优化数据率与重建质量之间的权衡。得益于灵活的非线性变换和端到端优化,这些基于学习的方法在性能上超越了传统压缩方法。

- 相关工作

- 研究 [25], [40]–[42] 为可学习的熵模型引入了自回归结构,以提取空间和通道维度中的相关上下文信息。这些上下文利用潜在特征中的内在相关性,以更准确地估计潜在特征的统计特性,从而提升率失真(rate-distortion,RD)性能。

- 局限性:以往的数据压缩方法通过传统指标(如峰值信噪比,PSNR)评估重建质量,主要集中于像素空间中的高保真图像重建。这种设计鼓励模型捕获视觉数据中的通用特征,而非提取特定任务相关的信息,导致信息冗余和过高的通信开销。

- 克服:本工作考虑基于面向任务的通信原则进行特征压缩,通过直接优化传输开销与下游任务性能之间的权衡,消除视觉数据中与任务无关的冗余信息。

2.3 LMM推理加速

- 相关工作

- 一些方法 [31], [43], [44] 尝试基于注意力得分丢弃不重要的视觉token或由这些token生成的关键-值(KV)缓存。

- 局限性:LMM推理通常发生在边缘服务器上,这些方法无法缓解设备-边缘协同推理框架中的数据传输开销。

- 其他研究 [28], [30], [45][47] 引入了可学习结构以选择或提取关键特征。

- 局限性一:这些基于学习的方法需要在大规模数据集上进行广泛训练,以识别对下游任务至关重要的特征,从而导致部署成本高昂。

- 局限性二:许多这类方法对每个小网格的视觉特征应用相同的操作,而忽略了图像不同区域语义复杂性的显著差异。 因此,这些空间不变的方法无法有效提取与任务相关的信息的紧凑表示,降低了压缩效率。

- 一些方法 [31], [43], [44] 尝试基于注意力得分丢弃不重要的视觉token或由这些token生成的关键-值(KV)缓存。

- 克服:本工作提出了一种 无需训练的特征合并模块(FMM) ,在特征投影之前合并视觉特征,从而同时减少数据传输开销和LLM推理延迟。

3 系统模型

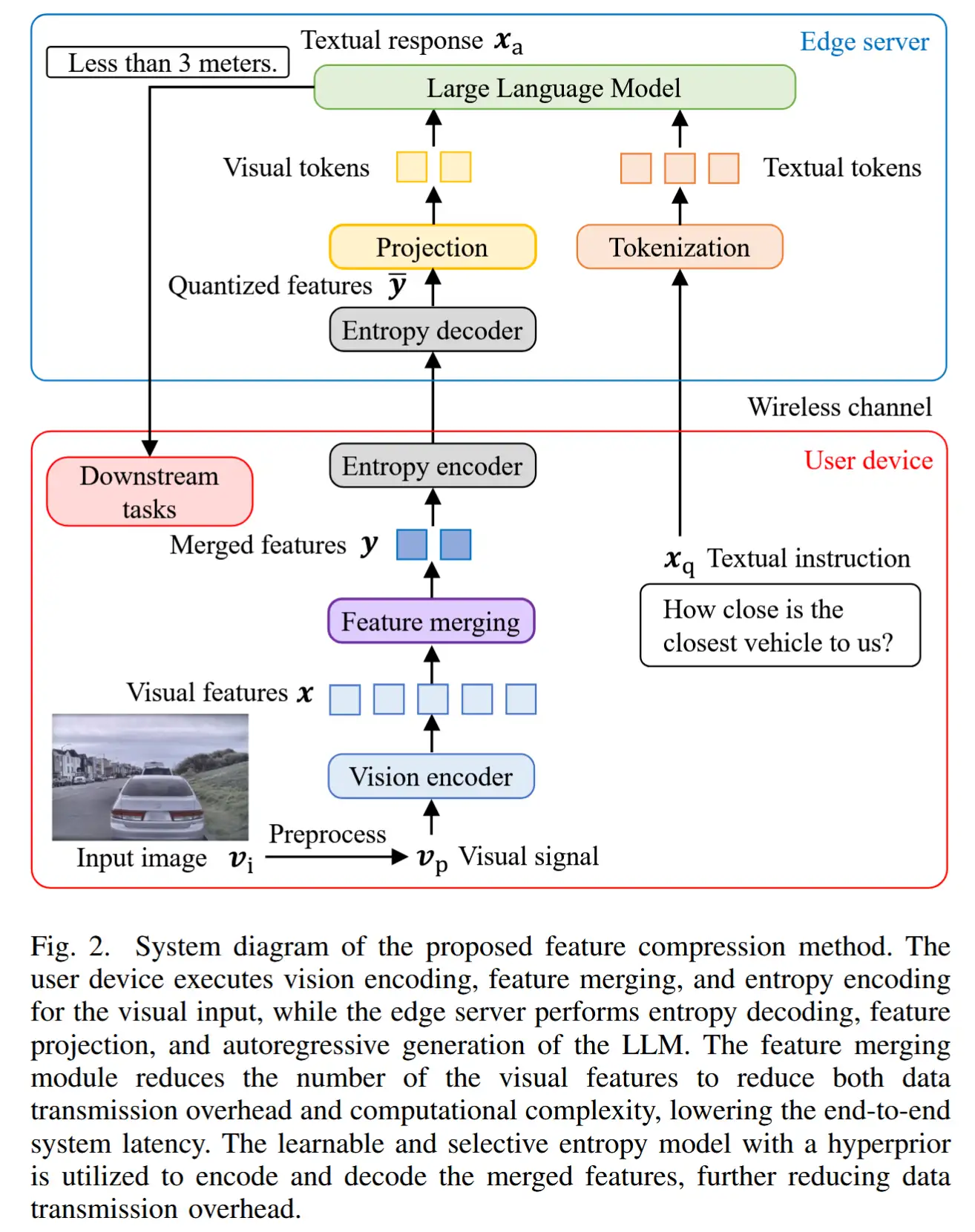

- 模型架构如图2所示

- 用户设备对输入图像进行处理和编码,然后将编码后的视觉特征与文本指令一起传输到边缘服务器以进行LMM推理。

- 具体而言,用户设备接收两种模态的输入:一种是用自然语言描述用户请求的文本指令,另一种是包含下游任务所需语义信息的视觉输入。

- 图像处理

-

图像块:每张图像被表示为一个像素级RGB强度的张量 v_i \in R^{h×w×3} 。为了保留输入图像的细节信息,图像被填充并分割为 n_h × n_w 个图像块,每个图像块的分辨率为 p × p ,以满足视觉编码器的要求。

-

整体缩略图:此外,通过将原始图像填充为正方形并调整大小为单个图像块的尺寸(即 p × p )来创建输入图像的缩略图,从而捕获图像的整体结构。

-

视觉信号由详细的图像块和整体缩略图组成,表示为 v_p \in R^{n_p×p×p×3},其中 n_p = n_h × n_w + 1 表示图像块的总数(包括缩略图)。

-

用户设备利用预训练的 SigLIP 视觉编码器 将视觉信号转换为视觉特征,表达为:

x = f_{vision(v_p)},- 其中,f_{vision}() 表示视觉编码器,x \in R^{n_p×n_v×d_v} 表示视觉特征,n_v 和 d_v 分别表示视觉特征的数量和每个视觉特征的维度。

-

特征合并模块:为了减少数据量并加速推理,作者提出了一种特征合并模块,将视觉特征 x 转换为合并特征 y \in R^{n_p×n_c×d_v} ,其中 n_c 是合并特征的数量。这些合并特征使用可学习的熵编码器 [23] 编码为比特流,然后通过无线信道传输到边缘服务器。

-

- 边缘服务器端处理

- 在边缘服务器上,接收到的文本指令通过预训练LLM的codebook进行分词处理。

- 同时,接收到的比特流由熵解码器解码,以恢复合并特征 ŷ 。随后,一个两层多层感知机(MLP)将合并特征投影到词嵌入空间中,从而将视觉输入与文本token对齐 [7]。

- 生成的视觉token与文本token连接在一起,构成LLM的输入。

- LLM生成的token序列记为 h_a,这些token被转换为明文形式的文本响应,并传输回用户设备以用于下游任务。

4 面向任务的特征压缩

- 面向任务的特征压缩(TOFC)

- 基于聚类的特征合并在该方法中,视觉特征通过聚类合并,并在特征投影之前使用可学习且选择性的熵模型进行编码,从而减少数据传输开销和端到端系统延迟。所提出的特征合并模块(FMM) 利用基于K近邻的密度峰值聚类(DPC-KNN)[48] 来减少视觉特征的数量,从而最小化数据传输和计算复杂度。(基于聚类的特征合并)

- 随后,采用带有超先验的可学习熵模型 [23] 对合并后的特征进行编码和解码,进一步减少传输开销。(基于可学习熵模型的编解码器)

- 为了提高熵模型估计的概率分布的准确性,根据视觉特征的特性自适应选择多个熵模型,从而提升压缩效率。(选择性熵模型)

第4部分公式太多了,难以提炼,索性直接翻译了。

4.1 基于聚类的特征合并

- FMM 将每个图像块中的 n_v个视觉特征划分为 n_c 个簇,并对每个簇中的特征进行平均,以获得合并特征。结果是,视觉特征的数量从 n_v 减少到 n_c ,仅相当于原始特征数量的 1.1% 至 4.4% 。

- 优点

- 这种减少显著降低了传输到边缘服务器的视觉特征的数据量。

- FMM 最小化了 LLM 处理的视觉token数量,从而大幅减少了边缘服务器上的 GPU 内存占用和计算负载。

- 数据传输和计算复杂度的双重降低有助于减小端到端系统的延迟,从而使延迟敏感任务成为可能,并提升用户体验。

- 公式化定义

-

令 d(x_{n,i}, x_{n,j}) 表示第 n 个图像块中第 i 个和第 j 个视觉特征之间的欧几里得距离,并令 KNN(x_{n,i},K) 表示第 n 个图像块中与第 i 个特征 x_{n,i} 最接近的 K 个视觉特征的集合,不包括 x_i 本身。

-

第 n 个图像块中第 i 个特征的局部密度 \rho_{n,i} ,是基于该特征与其 K 个最近邻特征之间的距离计算的[48],表达式为:

\rho_{n,i} = \exp\left(-\frac{1}{K} \sum_{x_{n,j} \in \text{KNN}(x_{n,i}, K)} d(x_{n,i}, x_{n,j})^2\right). -

具有更高局部密度的特征更接近周围特征,因此更适合被选为聚类中心。

-

为了确保聚类中心分布在整个潜在空间中,计算第 n 个图像块中第 i 个特征与同一图像块中任何具有更高局部密度的特征之间的最小距离,记为 \delta_{n,i},定义为:

\delta_{n,i} = \begin{cases} \min_{j : \rho_{n,i} < \rho_{n,j}} d(x_{n,i}, x_{n,j}), & \text{if}\ \ \exists j, \rho_{n,i} < \rho_{n,j}, \\ \max_{j} d(x_{n,i}, x_{n,j}), & \text{otherwise}. \end{cases}- 局部密度最高的视觉特征被赋予最大距离,以便它能够被选为聚类中心。

-

选择 \delta_{n,i}×\rho_{n,i} 值最高的 n_c 个特征作为聚类中心,其余特征被分配到与其最近的聚类中心所属的簇中。最后,对每个簇内的视觉特征应用平均池化操作,以获得合并后的特征 y 。

-

- 选择使用 DPC-KNN 进行特征合并,主要基于以下两个原因:

- 首先,所提出的基于聚类的方法能够适应图像不同区域语义复杂性的显著变化,这与传统的空间不变方法不同。传统方法对每个小网格的视觉特征应用相同的操作,而本文的方法动态地将所有视觉特征划分为多个簇,每个簇包含数量不等的特征。 因此,视觉特征是基于图像不同区域之间的语义相似性进行合并的,从而实现了更高的压缩效率。

- 其次,DPC-KNN 是一种无需训练的方法,可以直接与 LMM 结合使用,以有效减少视觉特征的数量。

4.2 基于可学习熵模型的编解码器 (Codec)

- 当每个视觉特征被转换到词嵌入空间时,其维度会显著增加。因此为了减小传输数据量,在特征投影之前采用熵编码,并传输比特流。

- 高效且紧凑的熵编码依赖于对离散变量的精确概率分布估计。然而,直接估计任意概率分布实际上是不可行的。

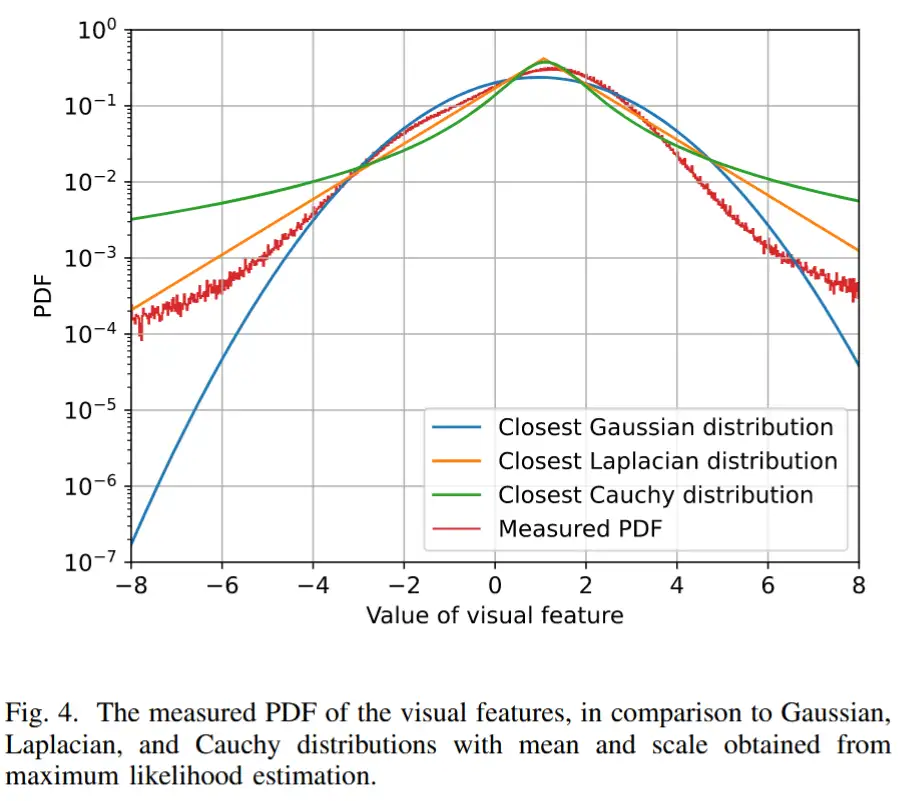

- 为了解决这一问题,使用拉普拉斯分布来建模合并后的特征 y,其中 mean 和 scale 由超先验 z 推导得出。超先验 z 的概率分布通过一个可学习的分解密度模型 [23] 进行估计。随后,y 和 z 都基于估计的概率分布进行量化并由熵编码器编码,从而在保持下游任务可接受失真的同时获得更紧凑的比特流表示。

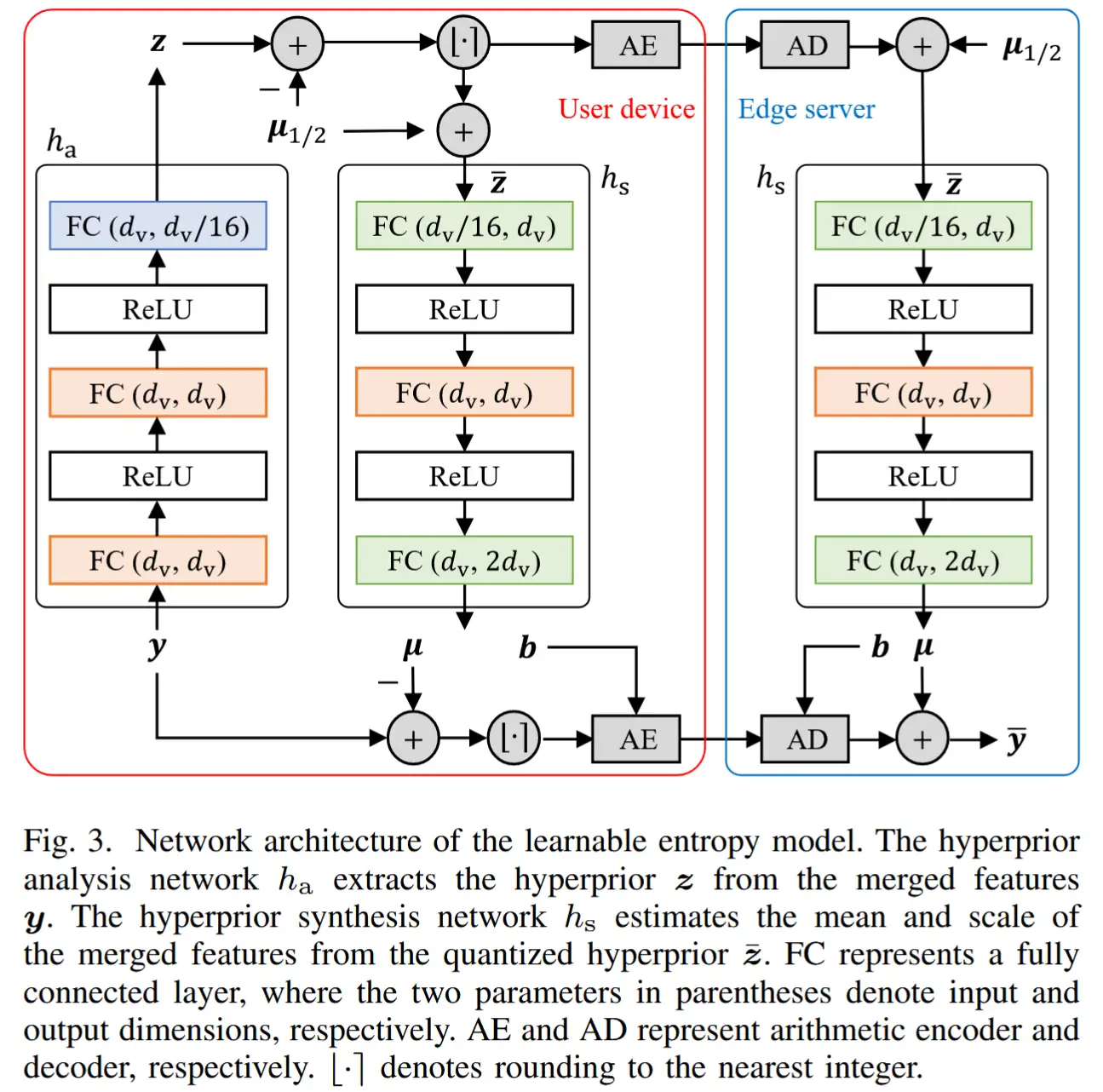

如图3所示

使用一个超先验分析网络 h_a 从合并特征 y 中提取超先验 z 。由于熵编码器操作的是整数,因此在熵编码之前,y 和 z 都需要进行量化。

合并特征的mean和scale通过超先验合成网络 h_s 从量化后的超先验 ẑ 中估计,表达式为:

μ 和 b 分别表示合并特征 y 的估计mean 和 scale 。

合并特征的量化引入了加性均匀噪声,表示为:

其中,\hat{y} 表示量化后的合并特征,o ∼ U(−0.5, 0.5) 是加性噪声,U(a, b)表示从 a 到 b 的均匀分布。

如图 4 所示,对视觉特征概率密度函数(PDF)的经验测量表明其近似为拉普拉斯分布。

因此,\hat{y} 的概率分布被建模为拉普拉斯分布与均匀分布的卷积,表示为:

其中,L(μ,b) 代表一个拉普拉斯分布,其均值向量为 μ,尺度向量为 b,符号 * 表示卷积。同样,量化的超先验 \bar{z} 的概率分布表示为:

其中,p(z) 是对 z 的估计概率分布 [23]。

为了允许梯度在量化操作中反向传播,作者在训练过程中使用直通估计器(Straight-Through Estimator, STE) [41],其表达式如下:

其中 STE(x) = sg(round(x) − x) + x 是 STE 运算,sg(·) 是停止梯度运算符,round(·) 表示四舍五入到最接近的整数,μ_{1/2} 代表从学习到的概率模型中得到的 z 的中位数向量。

在训练过程中,熵模型学习在数据压缩与下游任务性能之间取得平衡。因此,总损失 L 由码率损失 R 和 失真损失 D 组成,表达式如下:

其中,\lambda 是拉格朗日乘子(Lagrange multiplier),用于控制 码率(Rate)和失真(Distortion) 之间的权衡。

失真损失通过下一个 token 预测的交叉熵损失来计算,其公式如下:

其中,h_{a,t} 表示LLM 预测的第 t 个 token,T 表示真实响应的长度。

码率损失通过量化合并特征和超先验的平均联合熵来计算,该熵基于概率分布估计 [23],其公式如下:

除了训练熵模型的参数外,还在视觉编码器上采用低秩自适应(LoRA),以调整视觉特征的概率分布,从而实现更灵活的数据大小。

此外,训练MLP 投影层的参数,以适应由于特征合并和量化所引入的视觉特征变化。

最后,使用 LoRA 对 LLM 进行微调,以弥合视觉特征压缩所带来的差距。

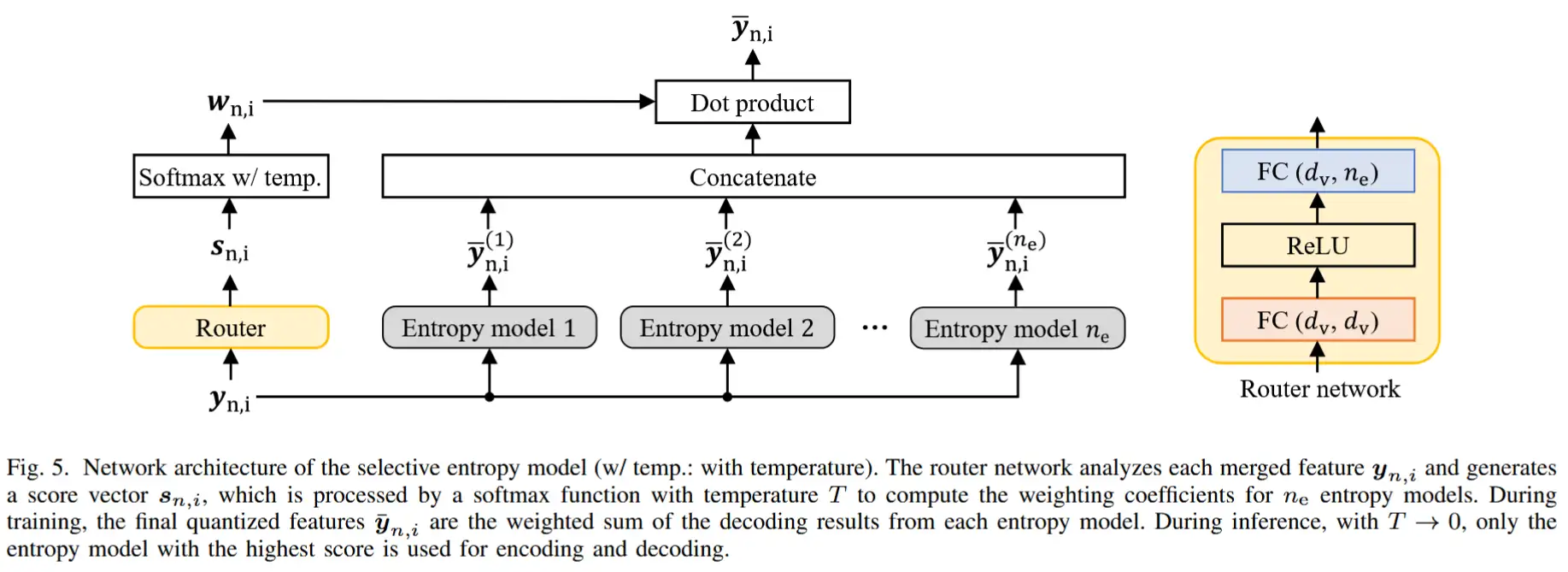

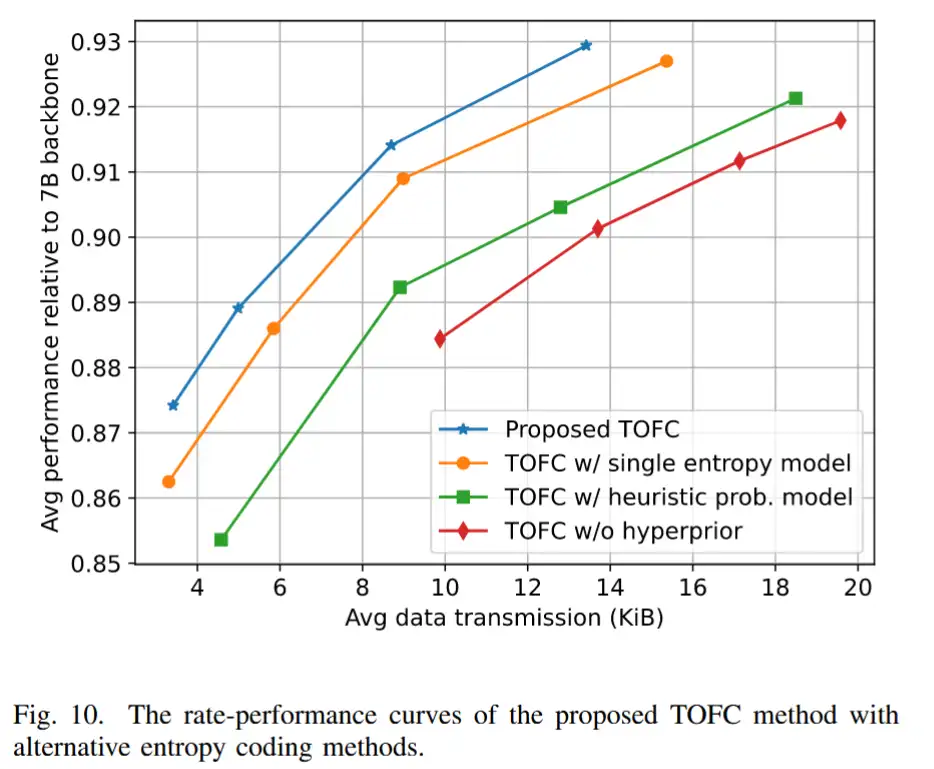

4.3 选择性熵模型

考虑到图像的语义多样性,单一熵模型无法准确估计合并视觉特征的统计信息。不准确的概率模型会在熵编码过程中引入额外开销,导致比特流长度超过量化特征的实际熵。

为消除这种冗余,作者采用多个熵模型,并根据视觉特征的特性自适应地选择最合适的熵模型。每个熵模型都专门用于编码特定的特征,从而使数据速率更接近实际熵,并提高整体压缩效率。

如图 5 所示,作者利用 路由网络(router network) 分析合并特征的属性,并为每个熵模型生成一个得分。具体来说,第 n 个 patch 中第 i 个特征的得分向量表示为:

其中 s_{n,i} 的长度等于熵模型的数量 n_e。在训练过程中,所有熵模型分别对合并特征进行编码和解码,而最终的量化特征是所有熵模型的解码结果的加权和,表达如下:

其中,w_{n,i}^{(e)} 和 \bar{y}_{n,i}^{(e)} 分别表示权重系数和第 n 个 patch 中第 i 个特征通过第 e 个熵模型解码后的结果。

类似地,公式 (11) 中的 码率损失 被所有熵模型的估计熵的加权和所替代,计算公式如下:

每个熵模型的权重系数由路由网络生成的得分计算得到,其计算方式为Softmax归一化:

其中,T 是温度参数,用于控制权重系数的分布。在训练初期,温度较高,不同熵模型的权重系数相近,使得所有熵模型都能学习基本的编码能力。随着训练的进行,温度逐渐降低,权重系数趋于收敛,最终在推理时收敛到单一的最优选择,从而使不同的熵模型能够专门化。

为了避免某些熵模型在训练过程中从未被选中的情况,在 (9) 中的 码率-失真损失(RD loss)中引入了平衡损失(balance loss),其表达形式如下:

其中,α 是平衡损失的权重系数。较高的 α 值 会促使每个批次中所有专家(熵模型)被均匀使用,但同时会抑制各熵模型的专门化。因此,α 的取值需要精心选择,以最大化压缩效率。详细的训练过程总结在 算法 1 中。

在推理阶段,每个压缩特征都会使用得分最高的熵模型进行编码和解码,这相当于温度参数趋近于零。权重系数的计算公式如下:

被选中的熵模型索引会作为辅助信息(side information)传输到边缘服务器,其数据量相较于编码特征而言可以忽略不计。

5 实验结果

5.1 实验设定

- 网络实现

- 主干模型:LLaVAOneVision-7B

- 视觉编码器:SigLIPSO400M

熵模型实现:基于 CompressAI - 其他参数具体见论文

- 训练细节

- 使用 LLaVA-1.5 第二阶段训练的指令微调数据。

- 训练轮数:一轮。

- 其他参数具体见论文

- 评估细节

- 评估基准(7 个 VQA 数据集):RealWorldQA、MME 感知评分、AI2D 测试集、MMBench 英文开发集、MMStar、ScienceQA 测试集、MMMU 验证集。

- 评估工具:VLMEvalKit

- 硬件:用户设备-NVIDIA Jetson AGX Orin;边缘服务器-多张 NVIDIA RTX 4090 GPU

- 对比方法:

- 传统图像压缩方法:JPEG、WebP

- 为了公平比较系统延迟,使用 FMM 结合 (10) 公式的失真损失训练模型,用于测量传统压缩方法(JPEG 和 WebP)的rate-performance曲线。

5.2 结果分析

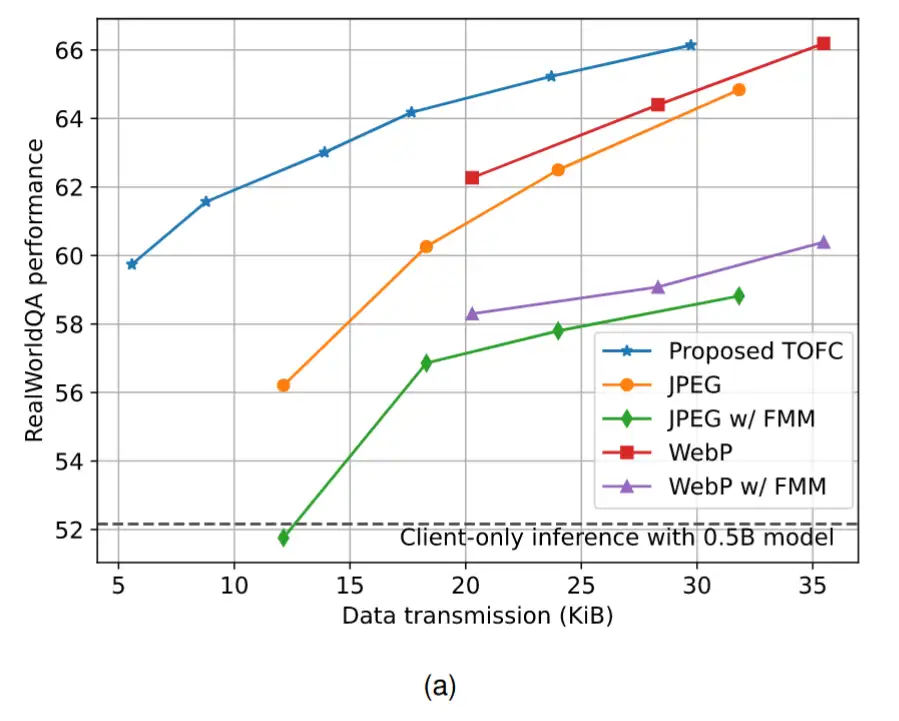

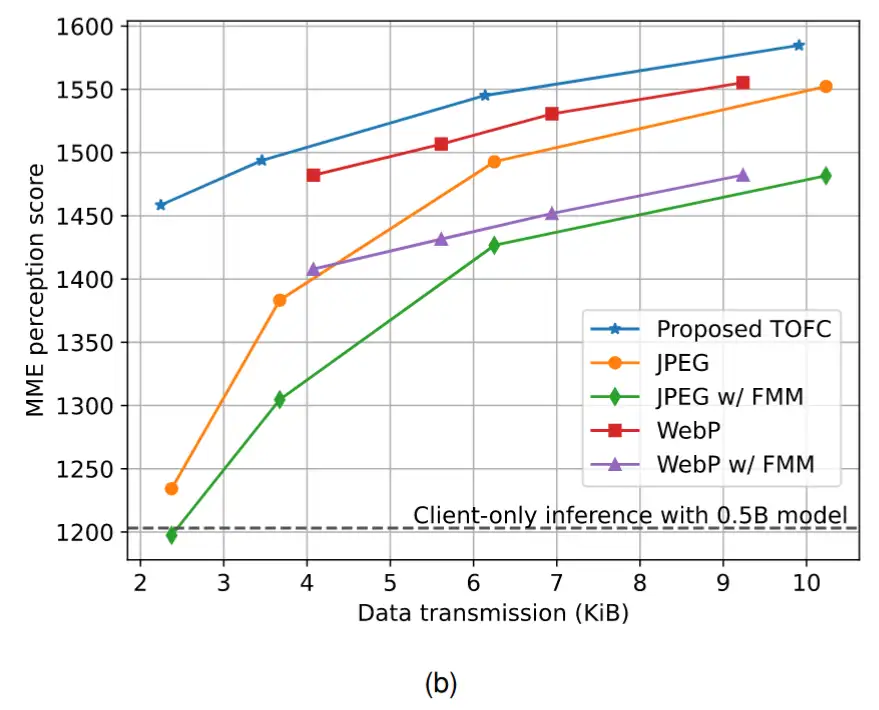

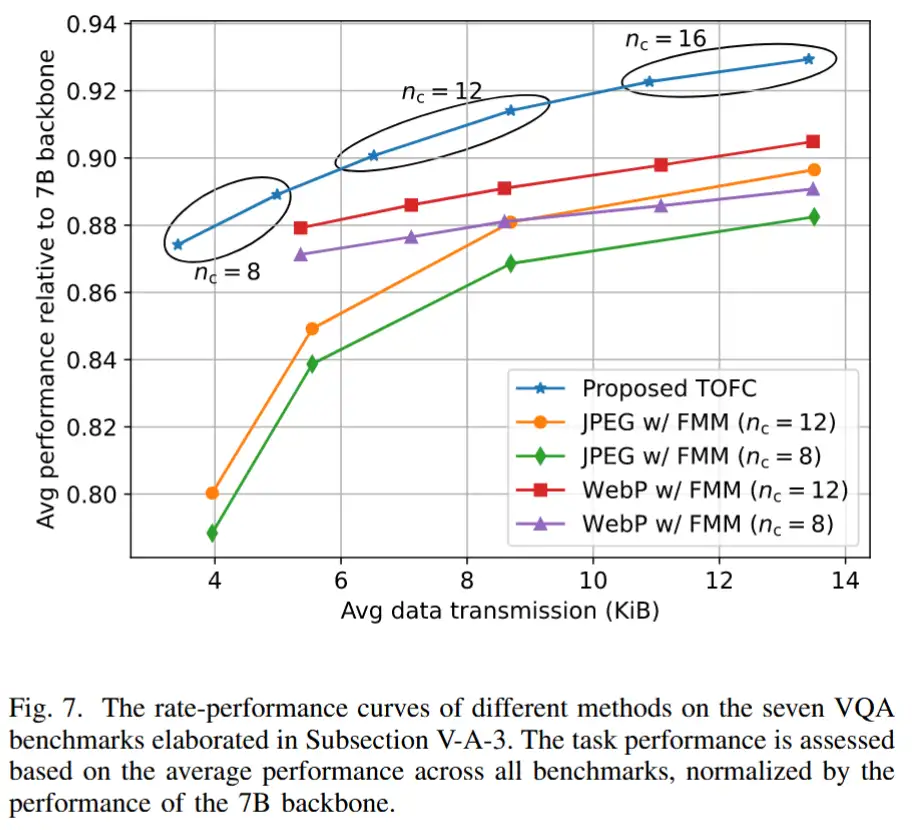

5.2.1 rate-performance曲线

作者用不同的拉格朗日乘子 λ 和合并特征的数量 nc 来训练所提出的 TOFC 模型的多个实例,以探索数据传输开销和任务性能之间的权衡。对于传统的 JPEG 和 WebP 压缩方法,调整它们的质量设置以获得速率-性能曲线。

RealWorldQA基准(高分辨率图像)

- TOFC方法 在任务性能相近的情况下,数据传输量显著降低。

- 当传统压缩方法(WebP/JPEG)结合FMM以匹配TOFC的系统延迟时:WebP和JPEG需分别增加 5.9倍 和 6.7倍 的数据传输量,才能达到与TOFC相当的任务性能。

MME基准(低分辨率图像)

- TOFC方法 在任务性能相近的情况下:

- 相比未使用FMM的WebP压缩 ,传输量减少 25% ;

- 相比未使用FMM的JPEG压缩 ,传输量减少 42% 。

- 当传统压缩方法结合FMM以匹配延迟时:WebP和JPEG需分别增加 3.2倍 和 3.6倍 的数据传输量,才能达到与TOFC相同的任务性能。

多基准综合评估(7个VQA基准)

-

任务性能评估标准 :所有基准测试的平均性能,以7B模型的性能为基准进行归一化。

-

TOFC的效率优势 :

- n_c=8 时,数据传输量比 WebP+FMM 减少 55% ,比 JPEG+FMM 减少 68% ;

- n_c=12 时,数据传输量比 WebP+FMM 减少 45% ,比 JPEG+FMM 减少 54% 。

-

核心结论 :

- TOFC通过动态丢弃与任务无关的冗余信息,在显著降低传输开销的同时保持高任务性能。

- 在延迟敏感任务(如实时交互)中,TOFC能够提供更优的用户体验和响应速度。

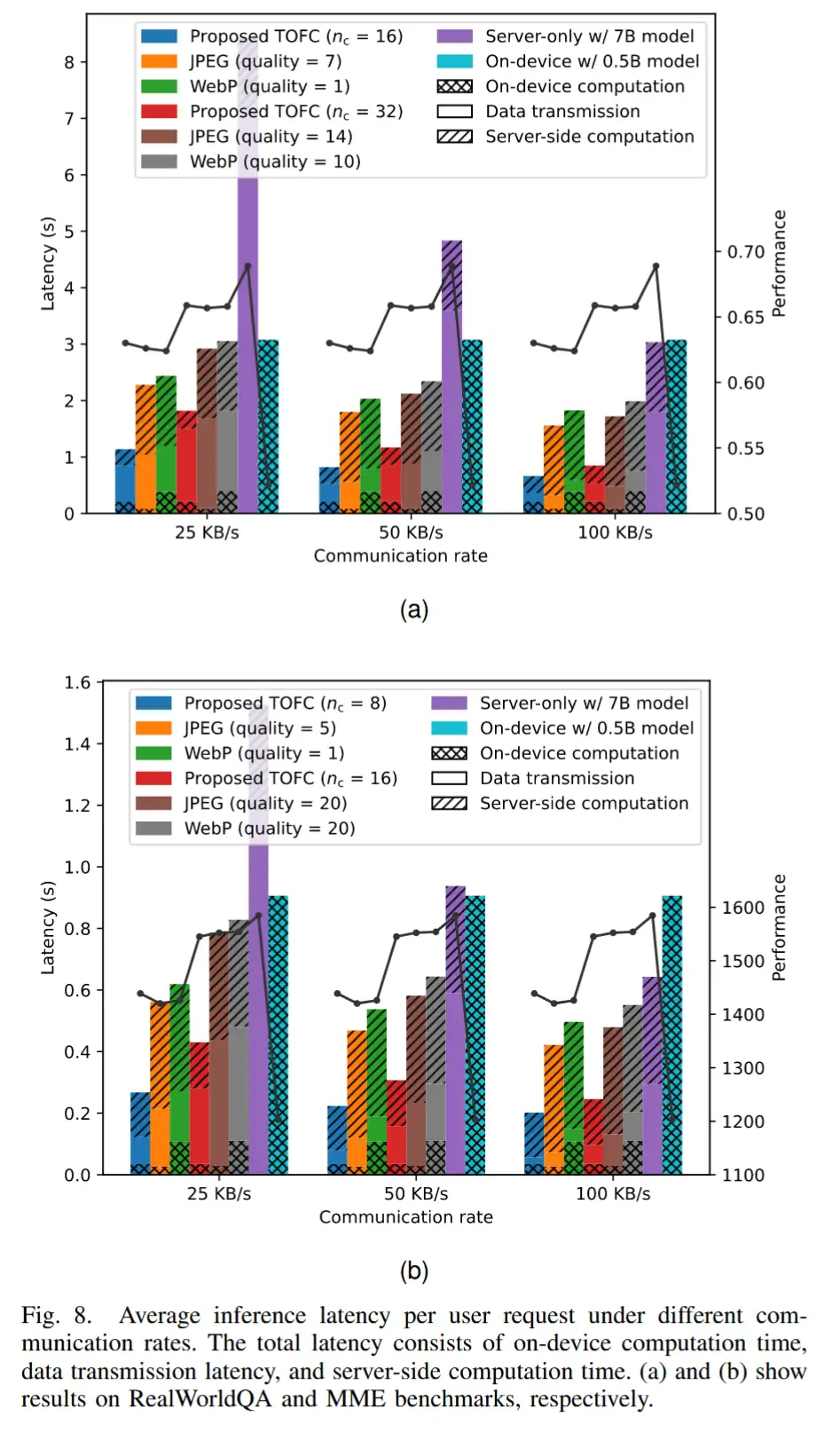

5.2.2 延迟分析

为验证 TOFC 方法的低延迟优势,作者比较了不同方法的端到端系统延迟(包括设备端计算时间、数据传输延迟和服务器端计算时间)。为确保公平对比,TOFC 的拉格朗日乘数 λ 和传统方法的压缩质量参数均经过精心选择,以达到相似的任务性能。

图8展示了在 RealWorldQA 和 MME 基准测试中,不同通信速率下的平均单次推理延迟。

核心结论

- 传输开销主导延迟 :在高分辨率场景下,数据传输延迟占系统延迟的大部分(如1.8秒),凸显减少传输开销的必要性。

- 端到端优化效果 :TOFC 通过 FMM模块 显著降低服务器端计算时间,同时减少传输数据量,实现更低的整体延迟。

- 普适性验证 :无论图像分辨率高低,TOFC 均表现出显著延迟优势,尤其适合资源受限的边缘设备-服务器协同推理场景。

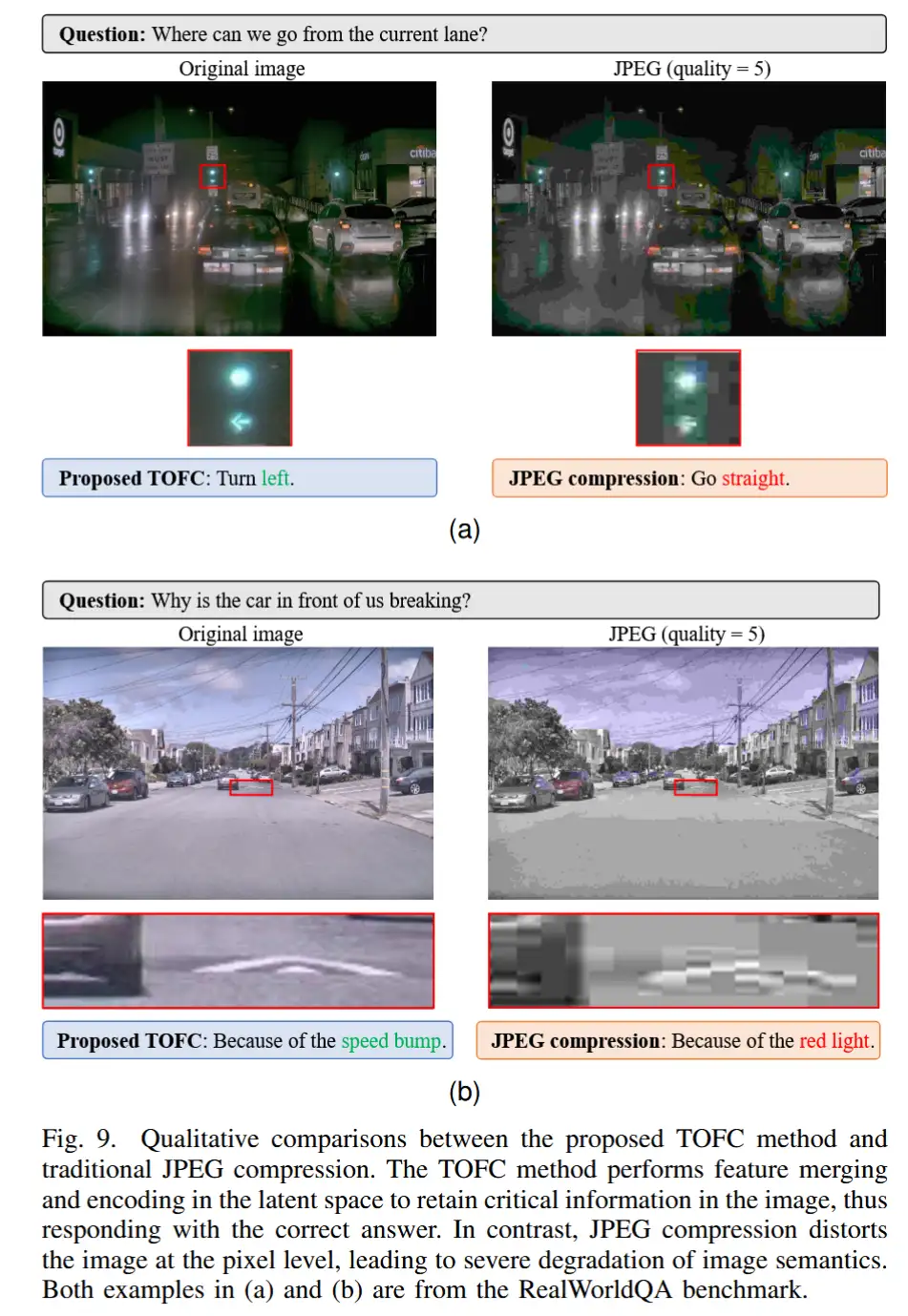

5.2.3 案例研究

- 传统像素压缩的局限性 :JPEG 等方法在压缩过程中破坏图像语义细节,导致下游任务性能显著下降。

- TOFC 的语义保留能力 :通过潜在空间的特征合并与编码,TOFC 在低数据量约束下仍能保留任务相关的关键信息,从而提升任务性能。

5.3 消融实验

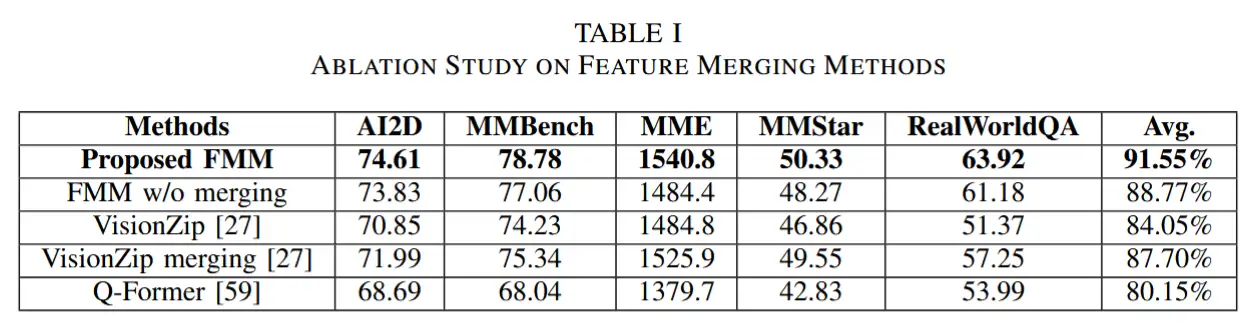

5.3.1 特征融合方法

对比方法说明

- FMM(无FMM) :仅保留 DPC-KNN算法 选择的聚类中心,丢弃其他特征而非合并到最近中心。

- VisionZip方法:选择四个获得最高注意力的视觉特征,并根据 [27] 的算法将未选中的特征合并为十二个特征。

- VisionZip合并方法 :直接采用 [27] 提出的合并算法生成全部十六个合并特征。

- Q-Former方法:使用十六个可学习查询(queries)从视觉特征生成的键值(key-value)嵌入中提取信息。

5.3.2 熵编码方法

6 结论

在本文中,研究了一种面向任务的特征压缩方法,用于多模态理解的设备-边缘协同推理框架。在该框架中,视觉特征通过聚类进行合并,并在特征投影之前由可学习的选择性熵模型进行编码。

所提出的FMM 方法利用DPC-KNN减少视觉特征的数量,从而最小化数据传输和计算复杂度。随后,采用带有超先验的可学习熵模型对合并后的特征进行编码和解码,进一步降低传输开销。

为了提高熵模型对概率分布的估计精度,基于视觉特征的特性自适应选择多个熵模型,从而提升压缩效率。

作者在七个 VQA 基准测试上进行了全面实验,验证了所提出的TOFC 方法的有效性。实验结果表明,TOFC 方法显著降低了数据传输开销和系统延迟,从而支持时延敏感任务并改善用户体验。